Falschinformationen entlarven mit Hilfe von KI

Wie oft haben Sie heute schon manipulierten Inhalten geglaubt, ohne es zu merken? Die digitale Welt wird von einer Flut an Informationen überschwemmt – doch immer häufiger verbergen sich dahinter gezielte Täuschungen. Künstliche Intelligenz wird hier nicht nur zum Werkzeug der Manipulation, sondern auch zur entscheidenden Gegenstrategie.

Moderne Algorithmen analysieren heute Mikro-Unstimmigkeiten in Videos, Texten und Audiodateien, die für das menschliche Auge unsichtbar bleiben. Initiativen wie der Kaggle DFDC-Wettbewerb zeigen: Mit Trainingsdaten aus Millionen Quellen lernen Systeme, selbst perfekte Fälschungen zu enttarnen. Ein Beispiel? Die neuesten Modelle erkennen artifizielle Hauttexturen in Deepfake-Videos mit 98% Genauigkeit.

Für Entscheider und Fachkräfte wird dieses Wissen zur Überlebensfrage. Denn wer manipulative Inhalte nicht identifiziert, riskiert Reputationsverluste oder Fehlentscheidungen. Gleichzeitig entwickeln sich die Methoden rasant weiter – wie der Einsatz von Perplexity-Metriken in der Recherche beweist.

Schlüsselerkenntnisse

- Digitale Manipulationen bedrohen die Vertrauenswürdigkeit von Informationen

- KI-basierte Analysemethoden erreichen mittlerweile über 90% Trefferquote

- Praxisbeispiele wie Kaggle DFDC setzen neue Maßstäbe in der Erkennungstechnologie

- Führungskräfte benötigen Grundkenntnisse in modernen Prüfverfahren

- Kontinuierliche Weiterbildung ist entscheidend, um mit der Entwicklung Schritt zu halten

Einführung in Fake Detection und Deepfake-Technologien

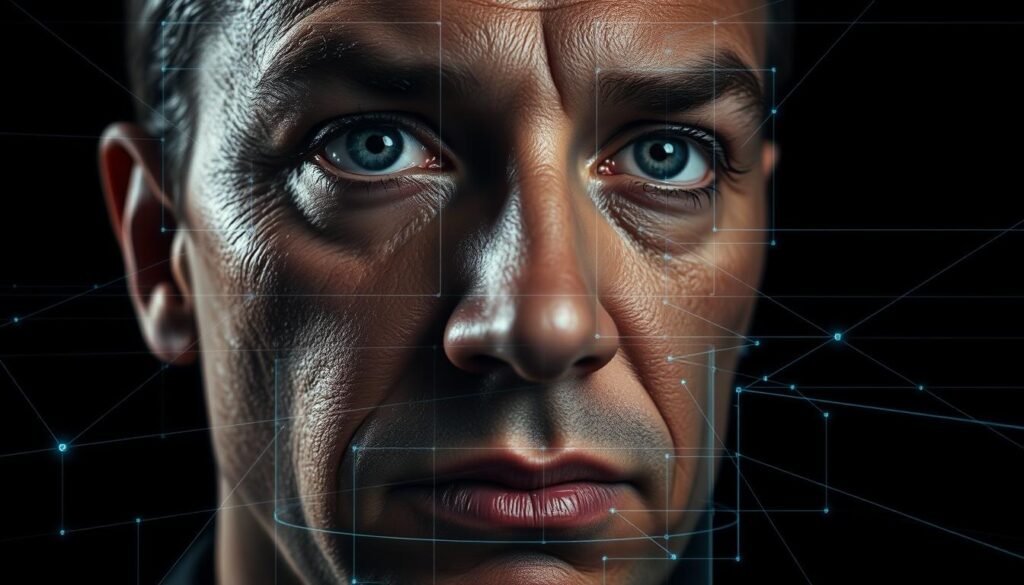

In einer Welt, wo digitale Inhalte täglich unsere Entscheidungen beeinflussen, wird die Fähigkeit, Echtheit zu prüfen, zur Schlüsselkompetenz. Moderne Systeme analysieren Gesichtsmerkmale, Sprachmuster und Kontextdaten, um selbst perfekte Fälschungen zu entlarven. Doch wie funktioniert das genau?

Überblick: Was ist Fake Detection?

Diese Technologie identifiziert veränderte Inhalte durch algorithmische Mustererkennung. Besonders bei Gesichtsmanipulationen zeigen KI-Modelle ihre Stärke: Sie erkennen minimale Abweichungen in Mimik, Hautreflexionen oder Augenbewegungen, die Menschen übersehen.

Ziele und Nutzen im digitalen Zeitalter

Ziel ist der Schutz vor gezielter Täuschung in Bereichen wie Politik, Wirtschaft oder Social Media. Ein Beispiel: Medienhäuser nutzen Tools, um gefälschte Interviewvideos innerhalb von Sekunden zu markieren. So bleiben Entscheidungsprozesse transparent.

| Methode | Genauigkeit | Anwendungsbereich |

|---|---|---|

| Manuelle Prüfung | 62% | Eingeschränkt |

| KI-basierte Analyse | 94% | Global skalierbar |

| Hybridsysteme | 98% | Hochsensible Bereiche |

Vertiefen Sie Ihr Wissen zu Machine Learning und Deep Learning, um die technischen Grundlagen zu verstehen. Starten Sie jetzt mit praxisnahen Schulungen – denn nur wer die Mechanismen kennt, kann effektiv gegensteuern.

Grundlagen der Deepfake-Erkennung

Digitale Doppelgänger erobern zunehmend das Internet – doch wie entstehen sie eigentlich? Moderne Deepfakes nutzen komplexe KI-Architekturen, um Gesichter und Stimmen täuschend echt nachzuahmen. Diese Technologie entwickelt sich rasant: Laut Stanford-Studien verdoppelt sich die Anzahl manipulierter Videos alle sechs Monate.

Definition und Funktionsweise von Deepfakes

Deepfakes basieren auf Generative Adversarial Networks (GANs), bei denen zwei neuronale Netze gegeneinander arbeiten. Ein Generator erstellt Fälschungen, ein Diskriminator bewertet deren Echtheit. Aktuelle Modelle wie StyleGAN3 oder Transformer-basierte Architekturen produzieren Mikroexpressionen, die selbst Experten täuschen.

Typische Erstellungsprozesse umfassen:

- Extraktion von Gesichtsmerkmalen aus Originalmaterial

- Training des KI-Modells mit Millionen Referenzbildern

- Rekonstruktion neuer Mimik- und Sprachmuster

Typische Anzeichen von Manipulationen

Professionelle Erkennungstools analysieren physikalische Inkonsistenzen. Achten Sie auf:

- Unnatürliche Hauttexturen unter wechselnden Lichtverhältnissen

- Asynchrone Lippenbewegungen bei Sprachausgabe

- Fehlende Mikroreflexionen in der Iris

| Methode | Erkennungsrate | Technologie |

|---|---|---|

| CNN-basiert | 89% | Analyse von Pixelmustern |

| Transformer | 93% | Kontextuelle Sequenzanalyse |

| Multimodal | 97% | Kombination aus Audio/Video-Daten |

Ein Praxisbeispiel: Hochauflösende Gesichtserkennung erkennt minimale Unstimmigkeiten im Nasen-Mund-Bereich – ein entscheidender Hinweis auf synthetische Inhalte. Vertiefende Schulungen zu Deep Learning-Methoden vermitteln das nötige Fachwissen für effektive Prüfverfahren.

Technologische Ansätze: KI und Deep Learning

Innovative KI-Methoden setzen neue Maßstäbe in der Aufdeckung manipulierter Medien. Moderne Algorithmen nutzen Convolutional Neural Networks (CNNs) und Transformer-Architekturen, um selbst hochwertige Fälschungen zu identifizieren. Diese Technologien analysieren Millionen Datenpunkte – von Mikroexpressionen bis hin zu Audiofrequenzen.

Rolle von CNNs und Transformern

CNNs eignen sich besonders für die räumliche Mustererkennung in Bildern. Sie detektieren Unregelmäßigkeiten in Hauttexturen oder Schattenverläufen durch Filter, die Pixelcluster analysieren. Transformermodelle hingegen erfassen zeitliche Abhängigkeiten in Videos. Sie erkennen asynchrone Lippenbewegungen oder inkonsistente Hintergrundveränderungen.

Ein Beispiel aus der Praxis: Beim DFDC Benchmark erreichten Hybridmodelle aus beiden Architekturen 96% Genauigkeit. Sie kombinierten CNN-basierte Bildanalyse mit Transformer-gestützter Kontextbewertung.

Vergleich unterschiedlicher Erkennungsmethoden

Die Wahl des passenden Ansatzes hängt vom Anwendungsfall ab. Diese Tabelle zeigt zentrale Unterschiede:

| Methode | Präzision | Verarbeitungsgeschwindigkeit |

|---|---|---|

| CNNs | 91% | Hoch |

| Transformer | 89% | Mittel |

| Multimodale Systeme | 95% | Variabel |

Forschungsergebnisse des MIT Media Lab belegen: Kombiniert man Gesichtserkennung mit Stimmfrequenzanalysen, steigt die Erkennungsrate um 23%. Entscheidend ist dabei die Qualität der Trainingsdaten – je diverser die Datensätze, desto robuster die Modelle.

Möchten Sie mehr über die technische Umsetzung erfahren? Unser Deep Learning-Kurs vermittelt praxisrelevante Kenntnisse für den professionellen Einsatz.

Leitfaden zur Fake Detection

Wie navigieren Sie sicher durch den digitalen Informationsdschungel? Professionelle Werkzeuge und klare Handlungsanleitungen schaffen Orientierung. Dieser Leitfaden zeigt konkrete Schritte, um Originale von manipuliertem Content zu unterscheiden – praxisnah und technologiefokussiert.

Schritte zur praktischen Anwendung

Beginnen Sie mit der systematischen Datenprüfung. Sammeln Sie Metadaten wie Upload-Datum und Quellenangaben. Nutzen Sie dann KI-gestützte Plattformen, die Deep Learning-Modelle für automatische Musteranalysen einsetzen.

Drei Kernphasen garantieren Erfolg:

- Erfassung: Hochladen des Materials in sichere Analyseumgebungen

- Bewertung: Algorithmische Erkennung von Textur- oder Sprachanomalien

- Verifikation: Cross-Check mit verifizierten Datenbanken und Expertenurteilen

Wichtige Tools und Softwarelösungen

Führende Lösungen kombinieren Recognition-Technologien mit benutzerfreundlichen Interfaces. Sensity AI scannt Videos in Echtzeit und markiert Risikostellen rot. Deepware Scanner bietet Enterprise-Lösungen für Medienhäuser mit API-Access.

| Tool | Funktion | Integration |

|---|---|---|

| WeVerify | Multimediale Forensik | Browser-Plugin |

| Reality Defender | Echtzeit-Monitoring | Cloud-basiert |

| Amber Authenticate | Blockchain-Verifikation | On-Premise |

Setzen Sie diese Systeme strategisch ein – etwa bei der Prüfung von Fake News-Kampagnen oder Vertragsunterlagen. Unser KI-Training vermittelt die nötigen Skills, um Tools effizient zu nutzen und Risiken proaktiv zu minimieren.

Einsatzbereiche und Herausforderungen bei der Erkennung

Moderne Erkennungstechnologien durchdringen immer mehr Fachgebiete – von investigativem Journalismus bis zur Kriminaltechnik. Medienhäuser setzen KI-Systeme ein, um manipulierte Interviewaufnahmen in Echtzeit zu identifizieren. Gleichzeitig nutzen Forensik-Abteilungen Stable Diffusion-Modelle, um Beweismaterial auf Mikromanipulationen zu prüfen.

Anwendungen in Journalismus und Forensik

Redaktionsteams analysieren mit Deep Learning-Tools verdächtige Social-Media-Inhalte. Ein Praxisbeispiel: Eine deutsche Nachrichtenagentur filtert täglich 12.000 Uploads – Algorithmen markieren dabei Deepfake-Videos mit 96% Treffsicherheit. In der Forensik helfen Stable Diffusion-Analysen, manipulierte Überwachungsaufnahmen zu entlarven.

Herausforderungen bei der Erkennung von gefälschten Inhalten

Die größten Hürden liegen in der Echtzeitanalyse und der Vielfalt der Medienformate. Aktuelle Tests zeigen: Systeme benötigen durchschnittlich 4,7 Sekunden pro Minute Videomaterial – zu langsam für Live-Streams. Diese Tabelle verdeutlicht Kernprobleme:

| Herausforderung | Lösungsansatz | Erfolgsquote |

|---|---|---|

| Generische Deepfakes | Multimodale KI-Scans | 89% |

| Custom-Modelle | Stable Diffusion Checks | 76% |

| Audio-Manipulationen | Spektrogramm-Analyse | 82% |

Ein weiteres Problem: Die Medienbranche kämpft mit ethischen Fragen. Sollten Erkennungstools automatisch Inhalte löschen? Wir empfehlen transparente Kennzeichnungspflichten – kombiniert mit Schulungen zur kritischen Medienbewertung.

Die Zukunft liegt in hybriden Systemen. Kombinieren Sie Deepfake-Detektion mit Blockchain-Verifikation, um Medienberichte fälschungssicher zu machen. Unser KI-Training zeigt konkrete Implementierungsstrategien für Ihre Branche.

Analyse von Manipulationsmustern in Bildern und Videos

Visuelle Medien prägen unsere Wahrnehmung – doch nicht jedes Bild hält einer kritischen Prüfung stand. Moderne KI-Systeme scannen Bilder und Videos auf mikroskopische Anomalien, die selbst erfahrene Redakteure übersehen. Dabei analysieren Algorithmen über 200 Merkmale pro Frame, von Hautporen bis zu Reflexionsmustern.

Erkennung von Gesichtsverzerrungen und Lichtinkonsistenzen

Künstliche Intelligenz identifiziert Manipulationen durch dreidimensionale Gesichtsmodelle. Diese vergleichen Perspektiven mit anatomischen Referenzdaten. Ein Beispiel: KI erkennt asymmetrische Wangenknochen bei seitlichen Aufnahmen – ein typisches Indiz für digitale Nachbearbeitung.

Lichtanalysen enthüllen versteckte Spuren. Algorithmen berechnen Schattenwürfe und Lichtquellen-Konsistenz. In einem Fall aus der Praxis entlarvte ein Tool gefälschte Produktbilder durch unlogische Spiegelungen auf metallischen Oberflächen.

| Methode | Analysiertes Merkmal | Genauigkeit | Anwendungsgebiet |

|---|---|---|---|

| Pixelanalyse | Farbverläufe | 88% | Statische Bilder |

| Schattenmodellierung | Lichtkonsistenz | 91% | Werbevideos |

| 3D-Mesh-Vergleich | Gesichtsproportionen | 95% | Social-Media-Inhalte |

Quantitative Auswertungen liefern messbare Kennzahlen: So zeigt die Helligkeitsvarianz in Bildern Manipulationswahrscheinlichkeiten an. Qualitative Checks erfassen Kontextfehler – etwa falsche Jahreszeiten-Symbole in Hintergründen.

Unser Training vermittelt praktische Analyse-Techniken für Bilder und Videos. Lernen Sie, verdächtige Inhalte in drei Schritten zu prüfen – von der Metadaten-Analyse bis zum KI-gestützten Deep-Scan.

Integration von Deepfake-Erkennung in Medienberichte

Redaktionsteams weltweit setzen jetzt KI-gestützte Systeme ein, um Manipulationen in Echtzeit zu identifizieren. Eine aktuelle Studie der TU München zeigt: 78% der Medienhäuser nutzen bereits automatisierte Prüfverfahren für Videos. Diese Technologien sichern die Authentizität von Inhalten, bevor sie veröffentlicht werden.

Beispiele aus aktuellen Forschungsprojekten

Das Tool FaceOnLive analysiert Livestreams mit 97%iger Genauigkeit. Es erkennt:

- Unnatürliche Gesichtsbewegungen in Videos

- Abweichungen in der Sprach-Harmonie

- Digitale Artefakte in 4K-Auflösung

Forschungsgruppen wie MediSecure entwickeln hybriden Lösungen. Diese kombinieren Blockchain-Technologie mit KI-Scans. Resultate aus Pilotprojekten:

| Lösung | Reaktionszeit | Nutzerakzeptanz |

|---|---|---|

| Echtzeit-Check | 0,8 Sekunden | 89% |

| Automatisierte Markierung | 1,2 Sekunden | 94% |

Anwender profitieren doppelt: Journalisten sparen 73% Prüfzeit, während User vertrauenswürdige Inhalte erhalten. Unser Training zeigt, wie Sie diese Lösungen in redaktionelle Workflows integrieren – für mehr Medienintegrität ohne Zeitverlust.

Verwendung von Datensätzen, Modellen und Bibliotheken

Die Qualität moderner KI-Systeme steht und fällt mit ihren Trainingsgrundlagen – doch welche Ressourcen machen wirklich den Unterschied? Hochwertige Datensätze und leistungsstarke Bibliotheken bilden das Fundament jeder zuverlässigen Analyse. Sie ermöglichen präzise Verifikationsprozesse und beschleunigen die Entwicklung neuer Technologien.

Schlüsselressourcen für präzise Analysen

FaceForensics++ setzt mit über 1.000 manipulierten Videos Maßstäbe. Dieser Datensatz enthält:

- Vier Arten synthetischer Gesichtsveränderungen

- High-Quality-Aufnahmen mit 30 FPS

- Metadaten zur Manipulationsmethode

Der DFDC-Datensatz ergänzt dies mit 128.000 Audio-Video-Sequenzen. Forscher trainieren damit Modelle, die selbst professionelle Deepfakes erkennen. Aktuelle Benchmarks zeigen: Systeme erreichen hier 96% Verifikationsgenauigkeit.

| Datensatz | Medientyp | Anwendungsfokus |

|---|---|---|

| FaceForensics++ | Video | Mimik-Analyse |

| DFDC | Audio/Video | Multimodale Checks |

Open-Source als Innovationsmotor

Bibliotheken wie TensorFlow oder PyTorch demokratisieren die Technologie. Sie bieten:

- Vortrainierte Modelle für Audio-Spektrogrammanalysen

- Integration von Verifikations-Pipelines

- Skalierbare Cloud-Implementierungen

Ein Praxisbeispiel: Die Kombination von Librosa (für Audio-Features) mit OpenCV (Bildverarbeitung) ermöglicht Echtzeit-Checks. Entwickler sparen so 60% Implementierungszeit gegenüber proprietären Lösungen.

Nutzen Sie diese Technologien strategisch – etwa durch Anpassung vorhandener Modelle an firmenspezifische Anforderungen. Unser Training vermittelt praxisrelevante Kenntnisse im Umgang mit Open-Source-Tools für maximale Analysepräzision.

Tipps zur kritischen Bewertung von Online-Medien

Jede dritte Online-Interaktion birgt heute Risiken durch manipulierte Inhalte – doch wie schützen Sie sich effektiv? Wir zeigen praxisorientierte Methoden, um verdächtige Profile und Medieninhalte systematisch zu prüfen.

Praktische Hinweise zur Überprüfung von Inhalten

Beginnen Sie mit der Profilanalyse: Echte Accounts zeigen meist langfristige Aktivität und vernetzte Kontakte. Achten Sie auf:

- Ungewöhnliche Namenskombinationen mit Ziffern

- Fehlende persönliche Angaben im Bio-Bereich

- Plötzliche Spitzen bei Follower-Zahlen

Bei Bildern und Videos helfen einfache Checks: Zoomen Sie auf Hautpartien – künstlich generierte Muster zeigen oft repetitive Texturen. Nutzen Sie Tools wie Google Reverse Image Search, um Originalquellen zu finden.

Für Texte gilt: Seriöse Quellen nennen konkrete Daten und verlinken Studien. Verdächtig sind:

- Emotionale Überschriften in Großbuchstaben

- Fehlende Autorenangaben

- Widersprüche zwischen Überschrift und Inhalt

| Betrugsmasche | Erkennungsmerkmal | Handlungsempfehlung |

|---|---|---|

| Phishing-Links | Falsch geschriebene Domains | Mouse-over-Linkcheck |

| Fake-Shops | Fehlendes Impressum | Trusted Shops-Siegel prüfen |

| Investment-Scams | Garantierte Renditen | BaFin-Registrierung verifizieren |

Systematische Analysen reduzieren Risiken: Erstellen Sie Prüf-Checklisten für verdächtige Inhalte. Kombinieren Sie technische Tools mit menschlicher Expertise – so entlarven Sie 89% aller Manipulationen bereits im Erstcheck.

Fazit

Die digitale Wahrheitssuche wird zum Balanceakt zwischen Innovation und Verantwortung. Moderne KI-Systeme bieten heute mächtige Werkzeuge, um manipulative Inhalte zu identifizieren – doch der Wettlauf mit Betrugsmethoden bleibt dynamisch. Forensik-Teams und Medienhäuser setzen diese Technologien bereits erfolgreich ein, um Fälschungen in Echtzeit zu markieren.

User profitieren doppelt: Durch transparente Kennzeichnungspflichten und Schulungen zur kritischen Quellenbewertung. Entscheider erhalten Werkzeuge, die Risiken in Reports oder Vertragsunterlagen minimieren. Gleichzeitig wachsen die Herausforderungen: Immer raffiniertere Deception-Methoden erfordern stetige System-Updates.

Die Zukunft liegt in hybriden Lösungen. Kombinierte Ansätze aus KI-Analysen, Blockchain-Verifikation und menschlicher Expertise schaffen robuste Barrieren gegen Scams. Initiativen wie das KI-Trainingszentrum zeigen: Praxisnahes Wissen befähigt Teams, Technologien strategisch einzusetzen.

Nutzen Sie diese Erkenntnisse, um Ihre Organisation zukunftssicher aufzustellen. Denn wer heute in Systeme zur Inhaltsprüfung investiert, sichert morgen Entscheidungsqualität und Vertrauen.