Datenaggregation und Textvorschläge

Wie können Firmen die Datenaggregation nutzen, um ihre Nachhaltigkeitsberichte zu verbessern? Moderne Datenanalyse hat die alten Berichterstattungswege überwunden. Sie bietet neue Wege, komplexe Probleme zu lösen.

Die KI für Nachhaltigkeitsberichte ändert, wie Firmen Daten bearbeiten und interpretieren. Wir erkunden, wie intelligente Technologien Textvorschläge machen und Datenanalyse verbessern.

Wir zeigen, wie Firmen moderne Datenaggregationstechniken nutzen. So erstellen sie genauer, schneller und wertvollere Berichte. Die Kombination von KI und Datenkonsolidierung öffnet neue Wege für strategische Entscheidungen.

Wichtigste Erkenntnisse

- Datenaggregation ermöglicht umfassende Einblicke in Unternehmensprozesse

- KI-gestützte Textvorschläge verbessern Berichtskonsistenz

- Moderne Datenanalyse reduziert manuelle Arbeitsschritte

- Nachhaltigkeitsberichte werden durch intelligente Technologien präziser

- Intelligente Aggregationstechniken steigern Effizienz und Genauigkeit

Grundlagen der Datenaggregation

Datenaggregation ist ein wichtiger Prozess in der Datenanalyse. Es hilft Unternehmen, große Datenmengen zu verdichten. So können sie wertvolle Erkenntnisse gewinnen.

Es wandelt rohe Daten in nützliche Zusammenfassungen um. Diese unterstützen strategische Entscheidungen.

Bei der Datenverarbeitung ist Aggregation sehr wichtig. Sie ermöglicht es, Daten nach bestimmten Kriterien zu gruppieren und zu zusammenzufassen. So wird die Informationslandschaft einfacher.

Definition und Bedeutung

Datenaggregation ist der Prozess, Informationen aus verschiedenen Quellen zu kombinieren. Ziel ist es, aussagekräftige statistische Kennzahlen zu erstellen. Diese bieten tiefe Einblicke in die Daten.

- Verdichtung großer Datenmengen

- Identifikation von Mustern und Trends

- Vereinfachung komplexer Informationen

Hauptkomponenten der Aggregation

Die wichtigsten Elemente der Datenzusammenfassung sind:

- Datensammlung aus unterschiedlichen Quellen

- Gruppierung nach definierten Kriterien

- Berechnung statistischer Kennwerte

- Visualisierung der Ergebnisse

Einsatzbereiche in der modernen Datenanalyse

Unternehmen nutzen Datenaggregation in Bereichen wie Finanzwesen, Marketing und Wissenschaft. Es ermöglicht präzise Analysen. So unterstützt es datengesteuerte Entscheidungsprozesse.

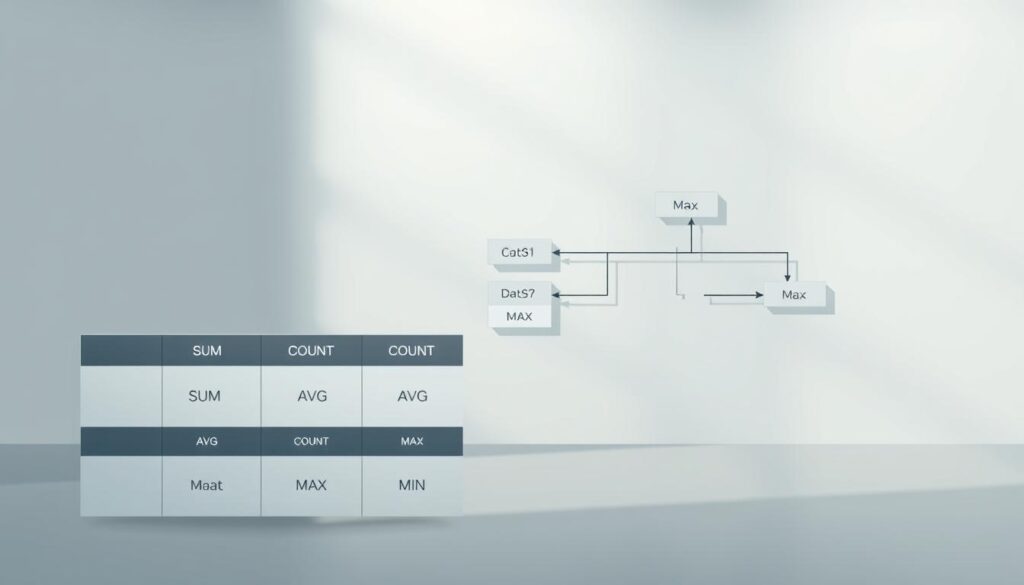

Aggregatfunktionen in SQL und Datenbanken

SQL-Aggregatfunktionen sind sehr wichtig für die moderne Datenanalyse. Sie helfen Entwicklern und Datenanalysten, komplexe Fragen zu stellen. So können sie nützliche Infos aus großen Datenmengen holen.

- COUNT(): Zählt die Anzahl der Datensätze

- SUM(): Berechnet die Summe numerischer Werte

- AVG(): Ermittelt den Durchschnittswert

- MIN(): Identifiziert den kleinsten Wert

- MAX(): Bestimmt den größten Wert

Diese Funktionen sind nützlich für die Gruppierung und Analyse von Daten. KI-gestützte Datenanalysetools passen perfekt dazu.

| Funktion | Beschreibung | Anwendungsbeispiel |

|---|---|---|

| COUNT() | Zählt Datensätze | Kundenanzahl pro Region |

| SUM() | Summiert numerische Werte | Gesamtumsatz pro Quartal |

| AVG() | Berechnet Durchschnittswerte | Durchschnittliche Verkaufspreise |

Aggregatfunktionen in SQL sind super für präzise Analysen. Sie helfen Firmen, bessere Entscheidungen zu treffen.

Zeitreihendatenbanken und ihre Rolle

Moderne Datenanalyse braucht fortschrittliche Speichertechnologien. Diese Technologien können komplexe zeitbasierte Informationen effizient verarbeiten. Zeitreihendatenbanken sind dabei sehr wichtig. Sie helfen in vielen Branchen, Daten zu speichern und zu verarbeiten.

Charakteristiken von Zeitstempeln und Datenpunkten

Zeitreihendatenbanken sind anders als normale Datenbanksysteme. Sie sind speziell für die Speicherung von zeitbasierter Daten optimiert. Sie können schnell Daten analysieren, weil sie chronologisch organisiert sind.

- Speicherung zeitbasierter Datenpunkte

- Effiziente Zeitstempel-Verwaltung

- Schnelle Datenanalyse mit chronologischem Kontext

Strategien zur Datenspeicherung

Um Daten in Zeitreihendatenbanken zu optimieren, braucht man spezielle Techniken. Dazu gehören:

- Komprimierung redundanter Zeitstempel

- Indexierung von Zeitintervallen

- Verteilte Speicherarchitektur

Abruf und Verarbeitung von Zeitreihendaten

Zeitreihendaten werden durch hochperformante Abfragemechanismen abgerufen und verarbeitet. Diese Mechanismen ermöglichen präzise Analysen in Echtzeit. Sie sind wichtig für wissenschaftliche und geschäftliche Zwecke.

Zeitreihendatenbanken verändern die Datenanalyse. Sie können große Mengen an zeitbasierter Daten schnell und effizient verarbeiten.

Dimensionen und Metriken in der Datenaggregation

Datenaggregation ist das Zentrum der modernen Datenanalyse. Sie hilft uns, komplexe Daten zu ordnen und zu verstehen. Dabei sind Datendimensionen und Datenmetriken sehr wichtig. Sie bieten uns verschiedene Sichtweisen und messbare Werte.

Metriken messen spezifische Datenaspekte. Sie können zum Beispiel Leistung, Umsatz oder Nutzung zeigen. Experten in der Datenanalyse nutzen Metriken, um Einblicke in Geschäftsprozesse zu bekommen.

- Dimensionen kategorisieren und gruppieren Daten

- Metriken liefern messbare Werte

- Kombinationen ermöglichen tiefgreifende Analysen

Um Daten effektiv zu aggregieren, muss man die Beziehung zwischen Dimensionen und Metriken verstehen. Jede Dimension kann mehrere Metriken enthalten, die unterschiedliche Perspektiven eröffnen.

| Dimension | Mögliche Metriken |

|---|---|

| Kundenverhalten | Kauffrequenz, Durchschnittsbestellwert |

| Produktkategorie | Umsatz, Gewinnmarge |

| Zeitliche Entwicklung | Wachstumsrate, Saisonale Schwankungen |

Die strategische Nutzung von Datendimensionen und Datenmetriken wandelt Informationen in wertvolle Erkenntnisse um. Unternehmen können so bessere Entscheidungen treffen und ihre Wettbewerbsfähigkeit verbessern.

KI für Nachhaltigkeitsberichte

Die digitale Transformation verändert die Nachhaltigkeitsberichterstattung durch KI. Unternehmen nutzen künstliche Intelligenz, um Nachhaltigkeitsprozesse zu verbessern. So werden diese Prozesse transparenter.

Moderne KI-Technologien analysieren Unternehmensdaten vollständig automatisch. Sie bieten tiefe Einblicke in die Nachhaltigkeitsleistung durch intelligente Datenverarbeitung.

Automatisierte Berichtserstellung

Die Automatisierung von Nachhaltigkeitsberichten bringt viele Vorteile:

- Schnellere Datenerfassung und -analyse

- Reduzierung menschlicher Fehlerquoten

- Konsistente Berichtsqualität

- Echtzeitanalyse von ESG-Metriken

Datenvalidierung und Qualitätssicherung

KI-Systeme prüfen Nachhaltigkeitsdaten auf Konsistenz und Plausibilität. Intelligente Algorithmen erkennen Unstimmigkeiten. So sichern sie die Datenintegrität.

Integration von ESG-Metriken

Die Einbindung von Environmental, Social, Governance-Kennzahlen wird durch KI präziser. Unternehmen können komplexe Nachhaltigkeitsdimensionen umfassend abbilden.

KI wandelt die Berichterstattung in ein strategisches Kommunikationsinstrument um. Sie macht es effizienter.

Aggregationstypen und ihre Anwendungen

Datenaggregation ist sehr wichtig in der modernen Datenanalyse. Sie hilft Unternehmen, große Datenmengen zu vereinfachen. So können sie wichtige Einblicke gewinnen. Es gibt verschiedene Arten, wie man Daten aggregieren kann.

- COUNT(): Zählt die Anzahl der Datensätze

- SUM(): Berechnet die Gesamtsumme numerischer Werte

- AVG(): Ermittelt den Durchschnittswert

- MIN(): Identifiziert den niedrigsten Wert

- MAX(): Bestimmt den höchsten Wert

Bei der Berichterstattung ist die Wahl des Aggregationstyps entscheidend. Finanzanalysten nutzen zum Beispiel SUM() für Umsatzberechnungen. Leistungsmessungen setzen oft AVG() ein. So profitiert die Datenanalyse von gezielter Anwendung.

Jeder Aggregationstyp hat spezifische Vorteile. Die Kunst liegt darin, den richtigen Typ für die Frage zu finden. So kann man die Daten am besten nutzen.

Strategien zur Datenkonsolidierung

Datenkonsolidierung ist wichtig für moderne Unternehmen. Sie hilft, Daten zu vereinheitlichen und zu verbessern. Der Hauptzweck ist die Integration verschiedener Datenquellen, um wertvolle Einblicke zu bekommen.

Es ist eine Herausforderung, verschiedene Datenquellen zu kombinieren. Dabei muss die Qualität und Integrität der Daten erhalten bleiben. Wir konzentrieren uns auf wichtige Aspekte der Datenintegration:

- Identifikation von Datenquellen

- Standardisierung der Datenformate

- Eliminierung von Redundanzen

- Sicherstellung der Datenkonsistenz

Methoden der Zusammenführung

Es gibt verschiedene Techniken für die Datenkonsolidierung. Wir unterscheiden zwischen:

- Vertikale Integration: Zusammenführung von Daten auf unterschiedlichen Detailebenen

- Horizontale Integration: Verbindung ähnlicher Datenstrukturen aus verschiedenen Quellen

Qualitätskontrolle

Die Qualität der Daten zu sichern, ist wichtig. Es erfordert systematische Überprüfungen:

| Qualitätsmerkmal | Prüfkriterium | Bewertungsmethode |

|---|---|---|

| Vollständigkeit | Vollständige Datensätze | Statistische Analyse |

| Konsistenz | Einheitliche Datenformate | Automatisierte Validierung |

| Genauigkeit | Fehlerfreie Einträge | Stichprobenprüfungen |

Best Practices

Für erfolgreiches Datenmanagement sind Strategien wichtig:

- Regelmäßige Datenbereinigung

- Implementierung robuster Validierungsprozesse

- Nutzung moderner Konsolidierungstools

- Kontinuierliche Schulung der Mitarbeiter

Die richtige Datenkonsolidierung macht Informationen wertvoll. Sie bildet die Basis für datengetriebene Entscheidungen.

Business Intelligence und Datenaggregation

Business Intelligence (BI) verändert die Datenanalyse durch intelligente Techniken. Unternehmen nutzen BI, um große Datenmengen zu analysieren. So entstehen wichtige Erkenntnisse für bessere Entscheidungen.

Die Datenaggregation in BI konsolidiert Informationen aus verschiedenen Quellen. Durch klare Visualisierung finden Organisationen verborgene Muster. Diese beeinflussen ihre strategischen Entscheidungen stark.

- Transformation unstrukturierter Daten in aussagekräftige Berichte

- Identifikation von Geschäftschancen durch detaillierte Analysen

- Echtzeiteinblicke in Unternehmensperformance

Moderne BI-Tools bieten tiefgehende Datenanalyse. Sie gehen über einfache Berichte hinaus. Durch fortschrittliche Techniken werden große Datenmengen zu strategisch wertvollen Informationen.

| BI-Aggregationsmethode | Anwendungsbereich | Kernvorteil |

|---|---|---|

| Zeitreihenanalyse | Umsatzprognosen | Trendvorhersage |

| Geografische Aggregation | Marktexpansion | Regionale Performancebewertung |

| Multidimensionale Analyse | Unternehmenscontrolling | Ganzheitliche Perspektive |

Datenaggregation und Business Intelligence kombinieren sich zu einer starken Plattform. Unternehmen können so komplexe Datenlandschaften meistern. Sie gewinnen dadurch entscheidende Vorteile im Wettbewerb.

Räumliche Datenaggregation und Visualisierung

Die moderne Informationslandschaft legt großen Wert auf räumliche Datenanalyse. Geodaten bieten tiefgehende Einblicke in komplexe räumliche Zusammenhänge. Sie gehen weit über herkömmliche Analysemethoden hinaus.

Heute nutzen Unternehmen und Forschungseinrichtungen fortschrittliche Techniken. Sie zeigen geografische Informationen präzise und verständlich. Die Kartendarstellung hilft, große Datenmengen leicht zu interpretieren.

Geografische Datenanalyse: Methoden und Ansätze

Bei der räumlichen Datenanalyse werden verschiedene Techniken verwendet:

- Punktbasierte Verdichtung von Geodaten

- Regionale Zusammenfassung von Standortinformationen

- Gitterzellenbasierte Datenkonsolidierung

Visualisierungstechniken für räumliche Daten

Moderne Visualisierungsmethoden bieten verschiedene innovative Ansätze:

| Visualisierungstechnik | Anwendungsbereich |

|---|---|

| Heatmaps | Dichteverteilung von Ereignissen |

| Choroplethenkarten | Statistische Datendarstellung |

| 3D-Räumliche Visualisierungen | Komplexe geografische Analysen |

Die Interpretation von Geodaten erfordert spezialisierte Fähigkeiten. Unternehmen können durch gezielte Visualisierungstechniken wertvolle Erkenntnisse gewinnen. Sie können datengestützte Entscheidungen treffen.

Hierarchische Datenaggregation

Die hierarchische Datenaggregation hilft Unternehmen, komplexe Daten zu analysieren. Sie ermöglicht es, Informationen auf verschiedenen Ebenen zu verstehen. So können Daten von der Detail bis zur Gesamtübersicht zusammengefasst werden.

Kernelemente der hierarchischen Datenaggregation umfassen:

- Systematische Gruppierung von Datenpunkten

- Verdichtung von Informationen auf unterschiedlichen Hierarchieebenen

- Ermöglichung von kontextbezogenen Analysen

Ein Beispiel dafür sind Verkaufsdaten. Unternehmen können Umsätze von Filialen bis zur nationalen Ebene aggregieren. Diese Methode der Datenaggregation gibt Führungskräften tiefe Einblicke in die Geschäftsperformance.

Moderne Business Intelligence-Tools nutzen hierarchische Datenstrukturen. Sie helfen, komplexe Zusammenhänge zu visualisieren und strategische Entscheidungen zu treffen. Die Fähigkeit, Daten intelligent zu gruppieren und zu analysieren, ist ein großer Wettbewerbsvorteil in der digitalen Wirtschaft.

Aggregation in verteilten Systemen

Verteilte Systeme bringen große Herausforderungen für die Datenaggregation mit sich. Sie ermöglichen es, Daten über verschiedene Netzwerke und Orte zu sammeln und zu bearbeiten.

Das Ziel ist, Daten effizient zu konsolidieren und zu synchronisieren. Für die Datenaggregation in verteilten Systemen braucht man präzise Strategien und fortschrittliche Netzwerkprotokolle.

Netzwerkprotokolle für effektive Datenübertragung

Moderne Netzwerkprotokolle sind sehr wichtig für die Datenübertragung. Sie sorgen dafür:

- Daten werden sicher zwischen Knoten übertragen.

- Netzwerküberlastungen werden minimiert.

- Datenintegrität wird sichergestellt.

Datensynchronisation in komplexen Umgebungen

Die Synchronisation von Daten in verteilten Systemen erfordert komplexe Mechanismen. Zeitstempel und Konsistenzprotokolle helfen, dass Daten an allen Knoten aktuell und konsistent sind.

Unternehmen nutzen fortschrittliche Algorithmen, um die Datensynchronisation zu verbessern. So werden Konflikte minimiert und Daten in Echtzeit verarbeitet. Das ist wichtig in globalen Infrastrukturen.

Leistungsoptimierung bei der Datenaggregation

Effiziente Analysen hängen von der Leistungsoptimierung ab. Unternehmen müssen neue Wege finden, um Daten schneller zu verarbeiten. Dabei spielen verbesserte Aggregationsalgorithmen eine große Rolle.

Zu den wichtigsten Strategien zur Steigerung der Effizienz gehören:

- Optimierung von Indexierungstechniken

- Implementierung von Caching-Mechanismen

- Nutzung paralleler Verarbeitungsarchitekturen

Heutzutage setzen viele Firmen auf moderne Algorithmen. Diese helfen, die Datenverarbeitung zu beschleunigen. Die Wahl der richtigen Technologie kann die Leistungsoptimierung erheblich verbessern.

| Optimierungsmethode | Performanzsteigerung |

|---|---|

| Verteilte Systeme | Bis zu 70% schnellere Verarbeitung |

| In-Memory-Verarbeitung | 50% Zeitersparnis |

| Intelligente Partitionierung | 40% Ressourceneffizienz |

Der Schlüssel zur erfolgreichen Optimierung ist die ständige Analyse und Anpassung der Aggregationsprozesse. Unternehmen müssen flexibel sein und neue Technologien schnell nutzen.

Datenschutz und Compliance

Die Aggregation von Daten bringt große Herausforderungen für den Datenschutz. Unternehmen müssen sicherstellen, dass sie die DSGVO einhalten. Sie müssen auch hohe Standards in der Datensicherheit erreichen.

- Strikte Einhaltung der DSGVO-Richtlinien

- Implementierung robuster Sicherheitsmechanismen

- Transparente Datenverarbeitungsprozesse

- Schutz personenbezogener Informationen

DSGVO-Konformität in der Praxis

Unternehmen müssen systematische Ansätze entwickeln, um Datenschutz und Compliance zu gewährleisten. Sie müssen Technologien zur Anonymisierung und Pseudonymisierung sensibler Daten umsetzen.

Strategien zur Datensicherheit

Effektive Datensicherheitskonzepte benötigen mehrschichtige Schutzmaßnahmen. Verschlüsselungstechnologien und granulare Zugriffskontrollen sind wichtig. Sie verhindern unbefugten Datenzugriff.

Die konsequente Umsetzung von Compliance-Strategien schützt die Privatsphäre. Es stärkt auch das Vertrauen in Ihre Datenverarbeitungsprozesse.

Fehlerbehandlung und Anomalieerkennung

Datenaggregation ist wichtig für Fehlerbehandlung und Anomalieerkennung. Unternehmen brauchen starke Strategien, um Datenqualität zu sichern. Sie müssen auch unerwartete Abweichungen erkennen.

- Statistische Methoden zur Identifikation von Ausreißern

- Maschinelle Lernalgorithmen für Datenbereinigung

- Automatisierte Validierungsprozesse

Bei der Datenqualität sind verschiedene Techniken wichtig. Komplexe statistische Modelle helfen, ungewöhnliche Datenmuster zu erkennen. So können Unternehmen frühzeitig Probleme in ihren Daten erkennen.

Fehlerbehandlung braucht systematische Ansätze. Moderne Technologien erkennen und korrigieren Datenanomalien automatisch. Maschinelle Lernalgorithmen erkennen unerwartete Abweichungen schnell und genau.

Anomalieerkennung wird in vielen Branchen angewendet:

- Finanzsektor: Betrugserkennung

- Produktionsumfeld: Qualitätskontrolle

- Gesundheitswesen: Medizinische Diagnoseunterstützung

Investitionen in fortschrittliche Fehlerbehandlungssysteme sind lohnenswert. Sie verbessern die Datenqualität und machen die Datenanalyse effizienter und zuverlässiger.

Automatisierte Berichterstellung

Moderne Unternehmen nutzen automatisierte Berichte als wichtige Technologie. Diese Berichte sind nicht mehr manuell zu erstellen, sondern durch Systeme, die Daten in einfache Bilder umwandeln.

Kernkomponenten automatisierter Berichtssysteme umfassen:

- Dynamische Datenvisualisierung

- Echtzeitdatenextraktion

- Intelligente Datenaggregation

- Flexible Berichtsvorlagen

Automatisierte Berichte bringen viele Vorteile. Sie helfen, schnell Entscheidungen zu treffen und machen die Arbeit einfacher. Unternehmen können so genau sehen, wie ihre Geschäfte laufen.

Technologien wie KI und maschinelles Lernen verbessern die Berichterstellung ständig. Sie erkennen Muster, machen Vorhersagen und passen die Bilder an die Bedürfnisse des Unternehmens an.

Erfolgreiche automatisierte Berichte brauchen eine gute Planung. Unternehmen müssen ihre Daten, Tools und Analyseprozesse gut zusammenarbeiten lassen.

Fazit

Die Welt der Datenaggregation entwickelt sich schnell. Unternehmen sehen, wie wichtig KI-gestützte Analyse ist. Sie helfen bei der schnelleren und genauereren Verarbeitung großer Datenmengen.

Die Zukunft der Datenverarbeitung hängt von intelligenten Systemen ab. Diese Systeme sammeln und interpretieren Daten richtig. Firmen wie SAP und Deutsche Telekom investieren viel in diese Technologien.

Unternehmen müssen immer weiter wachsen, um erfolgreich zu sein. Die Nutzung von fortschrittlichen Datenaggregationstechniken und KI ist entscheidend. Investitionen in Dateninfrastrukturen und Analysefähigkeiten sind wichtig.

Wer Datenaggregation richtig nutzt, kann Geschäftsprobleme besser lösen. Die Technologie ermöglicht es, datenbasierte Strategien zu entwickeln und neue Lösungen zu finden.