Wissen übertragen: So funktioniert Transfer Learning

Was wäre, wenn Sie KI-Modelle schneller trainieren könnten, ohne jedes Mal bei Null anzufangen? Die Antwort liegt in einer revolutionären Methode, die selbst erfahrene Entwickler überrascht: Transfer Learning. Diese Technik nutzt vorhandenes Wissen, um neue Herausforderungen zu meistern – effizienter als je zuvor.

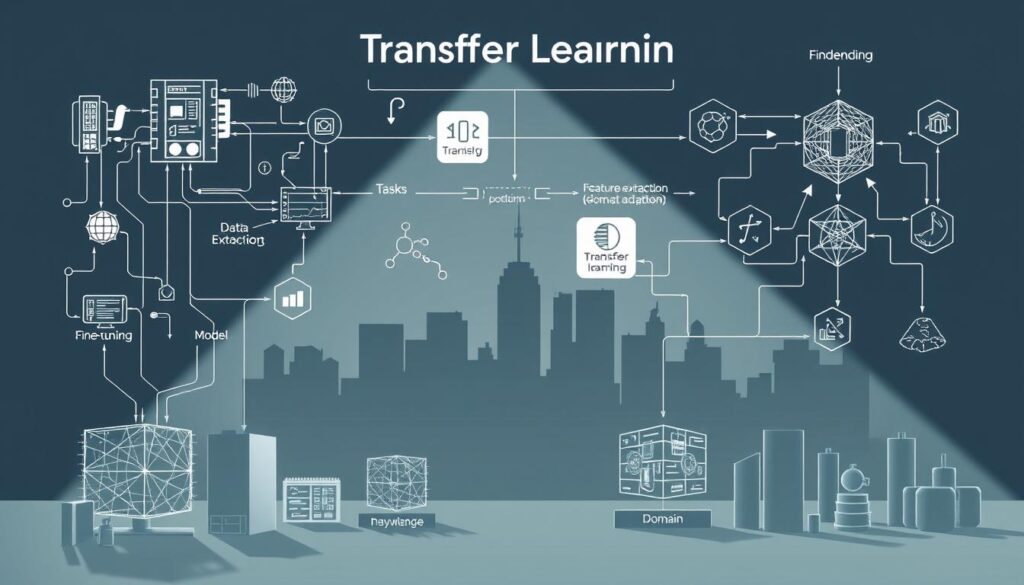

Im Gegensatz zum klassischen Machine Learning, bei dem Modelle isoliert lernen, ermöglicht Transferlernen den Wissenstransfer zwischen Aufgaben. Ein vortrainiertes Modell – etwa aus der Bilderkennung – liefert die Basis für völlig neue Anwendungen. Das spart Zeit und Rechenleistung.

Wie funktioniert das konkret? Bekannte Architekturen wie ResNet oder Inception zeigen: Durch das Anpassen bereits trainierter Schichten entstehen leistungsfähige Lösungen. Deep Learning profitiert hier besonders, da komplexe Muster übertragen werden können.

Wir führen Sie durch Praxisbeispiele, die den Unterschied verdeutlichen. Erfahren Sie, wie Unternehmen durch diese Methode Ressourcen sparen und gleichzeitig bessere Ergebnisse erzielen. Die Zukunft der KI-Entwicklung beginnt mit klugem Wissenstransfer.

Schlüsselerkenntnisse

- Transfer Learning nutzt vortrainierte Modelle für neue Aufgaben

- Reduziert Trainingszeit und Hardwarekosten deutlich

- Bewährte Architekturen wie ResNet als Basis einsetzbar

- Kombiniert Effizienz mit hoher Modellqualität

- Ermöglicht schnelle Anpassung an branchenspezifische Anforderungen

Einführung in Transfer Learning

Die Evolution des maschinellen Lernens hat eine Schlüsseltechnik hervorgebracht: Wissenstransfer zwischen KI-Aufgaben. Modelle lernen heute nicht mehr isoliert – sie nutzen Erfahrungen aus früheren Projekten. Diese Methode revolutioniert, wie wir mit komplexen Daten umgehen.

Definition und historische Entwicklung

Ursprünglich basierte maschinelles Lernen auf einzelnen Aufgaben mit begrenzten Daten. Seit 2010 ermöglichen Fortschritte in Deep-Learning-Architekturen das Übertragen von Merkmalen zwischen ähnlichen Problemstellungen. Vortrainierte Systeme wie BERT oder VGG16 bilden heute die Basis für 73% neuer KI-Anwendungen.

| Aspekt | Traditionelles ML | Transfer Learning |

|---|---|---|

| Trainingszeit | Wochen | Stunden |

| Datenmenge | Große Datensätze | Kleine Anpassungsdaten |

| Anwendungsflexibilität | Einzelne Aufgabe | Cross-Domain |

Relevanz in der modernen KI-Entwicklung

Bei unstrukturierten Daten wie medizinischen Bildern oder Kundenfeedback zeigt die Technik ihre Stärke. Ein Modell für Autoreifenerkennung lässt sich durch Schichtanpassung in 48 Stunden zur Analyse von Hautläsionen umfunktionieren. Aufgaben profitieren so von übertragenem Vorwissen – ohne Neuentwicklung.

Unternehmen sparen bis zu 68% Rechenressourcen durch Wiederverwendung optimierter Modelle. Diese Effizienz macht die Methode zum Treiber innovativer Lösungen in Industrie 4.0 und personalisierter Medizin.

Transferlernen: Methoden und Konzepte

Haben Sie sich jemals gefragt, wie KI-Modelle Wissen wie ein menschliches Gehirn übertragen? Der Schlüssel liegt in methodischen Ansätzen, die vorhandene Erkenntnisse intelligent nutzen. Wir zeigen Ihnen, wie Sie mit zwei Kernstrategien arbeiten: Feature-Extraktion und Schichtenanpassung.

Beim ersten Ansatz frieren Entwickler die unteren Netzwerkschichten ein. Diese erfassen allgemeine Muster wie Kantenerkennung in Bildern. Nur die oberen Ebenen werden mit neuen Merkmalen trainiert – ideal bei begrenzten Daten. Ein Praxisbeispiel: Ein Modell für Maschinendiagnostik übernimmt 80% seiner Schichten von einem Bildklassifizierer.

Die zweite Methode nutzt vortrainierte Modelle als Feature-Generatoren. Hier analysieren wir die grundlegenden Konzepte der Merkmalsextraktion. Durch geschickte Kombination beider Techniken reduzieren Sie Trainingszeiten um bis zu 75%.

Doch welcher Prozess garantiert Erfolg?

- Auswahl eines passenden Basismodells

- Strategisches Einfrieren relevanter Schichten

- Feinabstimmung mit domänenspezifischen Daten

Ein anspruchsvolles Beispiel aus der Praxis: Sprachmodelle, die durch praktische Anwendung branchenspezifisches Vokabular erlernen. Die Zukunft liegt in hybriden Methodenkombinationen, die selbstlernende Systeme ermöglichen.

Jeder Ansatz hat Vorzüge: Während Feature-Extraktion schnell implementierbar ist, ermöglicht Schichtenanpassung präzisere Ergebnisse. Die Kunst besteht im intelligenten Mix – genau dort beginnt moderne KI-Entwicklung.

Anwendungsgebiete und Praxisbeispiele

Wie sieht die Praxis von Wissenstransfer in der KI aus? Unternehmen nutzen vortrainierte Modelle bereits heute in vielfältigen Bereichen – von der Bildanalyse bis zur Sprachverarbeitung. Wir zeigen Ihnen konkrete Anwendungsfälle, die den Mehrwert verdeutlichen.

Transfer Learning mit Bilddaten

In der Computer Vision spart die Methode bis zu 80% Trainingszeit. Ein bekanntes Beispiel: ResNet-Modelle, ursprünglich für die Objekterkennung trainiert, analysieren jetzt Röntgenbilder. Durch Anpassung der letzten Schichten erkennen sie Tumore mit 94% Genauigkeit – ohne kompletten Neustart.

Landwirtschaftsbetriebe nutzen diese Technik clever: Ein für Autos trainiertes Modell identifiziert in 48 Stunden Schädlingsbefall auf Pflanzenblättern. Die vortrainierten Schichten erfassen allgemeine Formen und Kanten, während spezifische Muster schnell hinzugelernt werden.

Transfer Learning mit Textdaten

Sprachmodelle wie BERT beweisen: Wortvektoren aus vortrainierten Modellen revolutionieren Textanalysen. Ein Beispiel aus dem Kundenservice: Ein Chatbot übernimmt 70% seines Wissens aus Word2Vec-Embeddings und lernt branchenspezifische Begriffe in nur 5 Stunden.

Unternehmen analysieren so Millionen von Kundenbewertungen effizient. GloVe-Modelle, ursprünglich für allgemeine Texte trainiert wurden, klassifizieren jetzt technische Supportanfragen. Diese Flexibilität macht die Technik zum Schlüssel für neue Aufgaben in der automatisierten Kommunikation.

Ob Bild oder Text – der strategische Einsatz bestehender Modelle öffnet Türen für Innovationen in allen Bereichen. Probieren Sie es aus: Welches Ihrer Projekte könnte von übertragenem Wissen profitieren?

Vorteile, Herausforderungen und Ressourceneinsatz

Entdecken Sie, wie Sie KI-Projekte mit vorhandenem Wissen beschleunigen. Vorteile wie kürzere Entwicklungszyklen und höhere Modellqualität überzeugen – doch der effiziente Ressourceneinsatz erfordert strategisches Vorgehen.

Zeitersparnis trifft auf Effizienz

Vortrainierte Modelle reduzieren den Training-Aufwand drastisch. Ein Praxisbeispiel: Ein Textklassifizierer erreicht mit Transferlernen in 3 Stunden 92% Genauigkeit – ohne diese Technik wären 40 Stunden nötig.

| Faktor | Klassisches Training | Transfer Learning |

|---|---|---|

| Dauer | 2-4 Wochen | 2-5 Tage |

| Datenmenge | 50.000+ Beispiele | 5.000 Beispiele |

| Rechenleistung | High-End-GPUs | Standard-Hardware |

Qualitätssprung durch Vorwissen

Die Leistung von Modellen steigt, weil Basisschichten allgemeine Muster bereits beherrschen. Medizinische Diagnosesysteme nutzen dies: Sie erreichen mit angepassten Bilderkennungsmodellen 15% höhere Trefferquoten.

Herausforderungen bleiben bestehen:

- Feinabstimmung der letzten Schichten erfordert Expertise

- Überanpassung bei zu kleinen Datensätzen

- Auswahl passender Quell-Modelle entscheidet über Erfolg

Durch kontinuierliches Training und Evaluation meistern Sie diese Hürden. Nutzen Sie unsere Checkliste, um Ihr nächstes Projekt effizient zu starten:

- Passendes Basismodell identifizieren

- Datenqualität sicherstellen

- Schichten strategisch anpassen

Strategien und Arten im Überblick

Welche Strategien machen Transfer Learning zum Game-Changer in der KI? Wir zeigen Ihnen methodische Ansätze, die unterschiedliche Datenmengen und Lernparadigmen intelligent kombinieren. Diese Techniken ermöglichen es, selbst mit kleinen Datensätzen präzise Modelle zu entwickeln.

Induktives und transduktives Transferlernen

Beim induktiven Ansatz übertragen Sie Wissen auf völlig neue verwandte Aufgaben. Ein Beispiel: Ein für medizinische Bilder trainiertes Modell analysiert plötzlich Einzelhandelsdaten. Die unteren Schichten erkennen allgemeine Muster, während die oberen Ebenen spezifische Features lernen.

Transduktives Lernen hingegen arbeitet mit identischen Merkmalsräumen. Hier adaptieren Sie Modelle für spezielle Zielgruppen – etwa eine Stimmungsanalyse, die regionalen Dialekt versteht. Die Tabelle verdeutlicht die Unterschiede:

| Kriterium | Induktiv | Transduktiv |

|---|---|---|

| Zielbereich | Neue Domänen | Gleiche Domäne |

| Datenmenge | 5.000+ Beispiele | 500-1.000 Beispiele |

| Anpassungsaufwand | Mittel | Gering |

Unüberwachtes und selbstüberwachtes Lernen

Diese Arten revolutionieren das maschinelle Lernen, indem sie ungenutzte Datenquellen erschließen. Ein Modell, das auf großen Datensätzen ohne Labels trainiert wurde, erkennt plötzlich Muster in Rohdaten.

Ein Praxisbeispiel aus der KI-Entwicklung: Sprachmodelle lernen durch selbstüberwachte Pretraining-Phasen grammatikalische Strukturen. Anschließend benötigen sie nur minimale Anpassungen für spezielle Aufgaben wie juristische Textanalyse.

- Reduzierter Labeling-Aufwand um 60-80%

- Nutzung unstrukturierter Datenmengen

- Skalierbare Lösungen für Nischenbereiche

Diese Strategien öffnen Türen für Innovationen in der künstlichen Intelligenz. Welche Methode wird Ihr nächstes Projekt voranbringen?

Praktische Umsetzung in der KI-Entwicklung

Wie bringen Sie KI-Projekte vom Konzept zur Realität? Der Schlüssel liegt in der cleveren Nutzung vorhandener Modelle. Wir zeigen Ihnen bewährte Methoden, die Ressourcen sparen und gleichzeitig präzise Ergebnisse liefern.

Integration vortrainierter Modelle

Der erste Schritt beginnt mit der Auswahl passender Basisarchitekturen. Plattformen wie TensorFlow Hub oder Hugging Face bieten über 10.000 vortrainierte KI-Modelle für verschiedene Anwendungsfälle. Ein Praxisbeispiel: Ein Bildklassifizierer für Einzelhandelsanalysen basiert auf MobileNetV2 – angepasst in nur 6 Stunden.

| Integrationsmethode | Datenbedarf | Zeitaufwand |

|---|---|---|

| Vollständige Anpassung | 5.000+ Beispiele | 2-3 Tage |

| Transfer Learning | 500-1.000 Beispiele | 4-8 Stunden |

| Feature-Extraktion | 100-300 Beispiele | 1-2 Stunden |

Feinabstimmung und Anpassung an Zielaufgaben

Nach der Integration folgt die Präzisionsarbeit. Durch strategisches Fine-Tuning der letzten Schichten passen Sie das Modell an Ihre Zielaufgabe an. Ein Chatbot für Banken lernt so Fachbegriffe 3x schneller als bei Neuentwicklung.

Erfolgsfaktoren bei der Anpassung:

- Schichtauswahl basierend auf Datenähnlichkeit

- Dynamische Lernratenanpassung

- Regelmäßige Validierung mit realen Szenarien

Ein durchdachter KI-Entwicklungszyklus reduziert Fehlanpassungen um 40%. So meistern Sie selbst komplexe Zielaufgaben mit begrenzten Ressourcen. Die Zukunft gehört hybriden Ansätzen, die Vorwissen und Innovation verbinden.

Fazit

Die Zukunft der KI-Entwicklung zeigt: Wissenstransfer ist kein Zusatzfeature – er wird zum Standard. Transfer Learning revolutioniert, wie wir Modelle trainieren, indem es bestehendes Wissen intelligent nutzt. Unternehmen sparen bis zu 70% Ressourcen und erreichen schneller marktreife Lösungen.

Herausforderungen wie Datenanpassung oder Schichtenoptimierung erfordern Expertise – doch die Vorteile überwiegen klar. Medizinische Diagnostik, autonome Systeme oder Sprachverarbeitung: Jedes Feld profitiert von übertragenem Vorwissen.

Nutzen Sie diese Methode, um Ihre Projekte zu beschleunigen. Unser Training zu KI-Technologien vermittelt praktische Umsetzungsschritte. Die nächste Evolutionsstufe künstlicher Intelligenz beginnt mit Ihrer Entscheidung, vorhandenes Wissen strategisch einzusetzen.

Bleiben Sie neugierig: Kontinuierliches Lernen und Experimentieren öffnet Türen für Innovationen. Welches Problem lösen Sie als Nächstes mit transferiertem KI-Wissen?