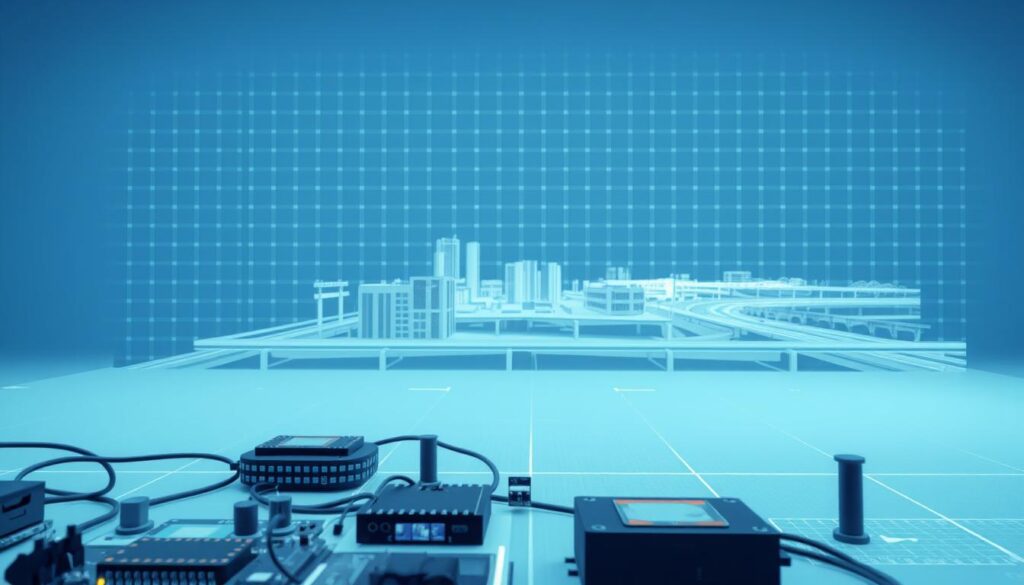

Virtuelle Testszenarien effizient erstellen

Was wäre, wenn Sie komplexe Prozesse in Minuten statt Wochen testen könnten? Die Antwort liegt in der Symbiose aus künstlicher Intelligenz und moderner Simulationstechnologie. Dieser Artikel zeigt, wie Sie durch intelligente Software Ressourcen sparen und gleichzeitig präzisere Ergebnisse erzielen.

Virtuelle Testszenarien revolutionieren Branchen wie die Logistik, wo KI-basierte Lösungen bereits heute Lieferketten optimieren. Wir erklären, wie Algorithmen reale Szenarien vorhersagen, Fehlerquellen identifizieren und Handlungsempfehlungen generieren – ohne teure physische Prototypen.

Der Schlüssel? Eine digitale Zwillingstechnologie, die durch maschinelles Lernen dynamisch reagiert. Statt starrer Modelle entstehen adaptive Systeme, die sich an wechselnde Rahmenbedingungen anpassen. So entfalten Sie das volle Potenzial Ihrer Prozesse.

Schlüsselerkenntnisse

- KI-gestützte Simulationen reduzieren Testzyklen um bis zu 70%

- Digitale Zwillinge ermöglichen Echtzeit-Analysen komplexer Systeme

- Kosteneinsparungen durch virtuelle Prototypen-Entwicklung

- Wettbewerbsvorteil durch schnellere Markteinführung neuer Lösungen

- Praxisanleitungen für die Integration in bestehende Workflows

Unser Guide führt Sie durch konkrete Anwendungsfälle – von der Datenaufbereitung bis zur automatisierten Ergebnisinterpretation. Entdecken Sie, wie Sie mit weniger Aufwand mehr erreichen.

Einführung in die Thematik

Digitale Innovationen verändern die Art, wie Unternehmen komplexe Systeme testen. Virtuelle Szenarien ermöglichen es, reale Bedingungen präzise nachzubilden – ohne Zeitverlust oder Materialkosten. Wir zeigen, warum diese Methode zum Game-Changer für die Industrie wird.

Bedeutung virtueller Testszenarien in der digitalen Transformation

Moderne Datenströme aus Sensoren, Maschinenprotokollen und Kundensystemen bilden die Grundlage präziser Modelle. Diese Echtzeit-Daten erlauben es, Prozesse nicht nur zu simulieren, sondern aktiv zu optimieren. Ein Beispiel: Logistikunternehmen nutzen solche Analysen, um Lieferrouten dynamisch an Staus oder Wetteränderungen anzupassen.

Der Einsatz virtueller Tests beschleunigt Entscheidungen und reduziert Risiken. Unternehmen identifizieren Schwachstellen, bevor sie entstehen – etwa in Produktionsketten oder Serviceabläufen. Drei zentrale Vorteile:

- Kosteneinsparungen durch vorausschauende Fehlererkennung

- Skalierbare Lösungen für unterschiedliche Branchen

- Schnellere Implementierung neuer Technologien

Forschung und Praxis verbinden sich hier auf einzigartige Weise. Während Algorithmen Muster erkennen, liefern Experten das nötige Fachwissen. Diese Symbiose treibt die Verbesserung bestehender Systeme voran – ein Kreislauf aus Lernen und Anpassen.

Herausforderungen wie Datenqualität oder Rechenkapazitäten bleiben bestehen. Doch die Chancen überwiegen: Wer heute in digitale Testverfahren investiert, sichert sich morgen den Wettbewerbsvorsprung.

Grundlagen der Künstlichen Intelligenz und Simulation

Moderne Technologien ermöglichen es, Realität im digitalen Raum vorwegzunehmen. Um dieses Potenzial voll auszuschöpfen, lohnt sich ein Blick auf die technischen Fundamente. Wir klären Schlüsselkonzepte, die Sie für den Einsatz virtueller Testverfahren benötigen.

Definitionen und zentrale Begriffe

Künstliche Intelligenz bezeichnet Systeme, die menschliche Entscheidungsmuster nachbilden. Im Gegensatz zu starren Algorithmen passen sie sich dynamisch an – etwa durch maschinelles Lernen. Letzteres trainiert Modelle mit Daten, statt jedes Szenario manuell zu programmieren.

Simulationen imitieren reale Prozesse durch mathematische Modelle. Sie testen “Was-wäre-wenn”-Szenarien risikofrei. Traditionelle Methoden basieren auf festen Regeln, während intelligente Systeme Muster erkennen und Prognosen optimieren.

Überblick zu Simulationsansätzen und KI-Technologien

Drei innovative Methoden prägen die Entwicklung:

- Agentenbasierte Modelle: Simulieren Interaktionen autonomer Einheiten

- Monte-Carlo-Simulationen: Analysieren Zufallseinflüsse durch Wiederholungen

- Neuronale Netze: Erkennen komplexe Zusammenhänge in Echtzeitdaten

Ein Praxisbeispiel: Hersteller nutzen diese Ansätze, um Produktionsengpässe vorherzusagen. Statt monatelanger Tests liefern digitale Zwillinge Ergebnisse in Stunden. So entstehen adaptive Lösungen, die sich ständig verbessern – ein Quantensprung für die betriebliche Effizienz.

KI in der Simulationsforschung

Wie können Unternehmen ihre Geschäftsabläufe mit digitalen Werkzeugen grundlegend verändern? Die Antwort liegt in der Verbindung von Echtzeitdaten und lernfähigen Algorithmen. Diese Kombination ermöglicht es, selbst komplexeste Vorgänge präzise nachzubilden – und dabei versteckte Optimierungschancen aufzudecken.

Vom Lagerhallenmanagement zur Produktionssteuerung

Logistikunternehmen nutzen lernfähige Systeme bereits heute, um Lieferketten zu revolutionieren. Ein Praxisbeispiel: Ein führender Spediteur reduzierte Leerfahrten um 23%, indem er Wetterdaten, Verkehrsmuster und Frachtaufkommen in Echtzeit analysierte. Möglich wurde dies durch trainierte KI-Modelle, die dynamisch auf Änderungen reagieren.

In der Fertigungsindustrie zeigt sich ähnliches Potenzial. Intelligente Steuerungen erkennen Materialengpässe Wochen vor ihrem Eintreten. Sie passen Produktionspläne automatisch an – ohne menschliches Zutun. Drei zentrale Vorteile:

- Sofortige Entscheidungsfähigkeit: Algorithmen verarbeiten Millionen Datenpunkte in Sekunden

- Ressourcenschonung: Energieverbrauch sinkt durch präzise Steuerung um bis zu 18%

- Skalierbarkeit: Lösungen funktionieren in Kleinbetrieben wie Konzernen

Das ungeschöpftes Potenzial liegt in der Integration bestehender IT-Systeme. Durch die Kombination von ERP-Daten mit Simulationen entstehen völlig neue Steuerungsansätze. Ein Automobilzulieferer konnte so seine Lagerhaltungskosten um 40% senken – ein Beleg für die transformative Kraft dieser Technologie.

Zukunftsorientierte Unternehmen setzen bereits auf selbstoptimierende Systeme. Diese lernen aus jedem Durchlauf und verbessern sich kontinuierlich. Der Schlüssel zum Erfolg? Ein strategischer Einsatz, der Fachwissen und maschinelle Intelligenz intelligent verknüpft.

Methoden und Technologien für effiziente Testszenarien

Effiziente Testszenarien entstehen durch das Zusammenspiel innovativer Methoden und leistungsstarker Technologien. Wir zeigen, wie Sie traditionelle Ansätze durch moderne Werkzeuge ersetzen – für präzisere Ergebnisse in kürzerer Zeit.

Maschinelles Lernen trifft Zufallsanalyse

Stochastische Verfahren berechnen Wahrscheinlichkeiten für verschiedene Szenarien. Kombiniert mit lernfähigen Algorithmen entstehen adaptive Modelle. Ein Beispiel: Ein Einzelhändler optimierte seine Lagerbestände um 35%, indem er saisonale Schwankungen und Lieferkettenrisiken simultan analysierte.

Moderne Tools wie STOCHOS automatisieren diese Prozesse. Sie generieren tausende Varianten in Minuten – manuell undenkbar. So identifizieren Sie versteckte Optimierungspotenziale, die klassische Simulationsmethoden übersehen.

Rechenpower meets Benutzerfreundlichkeit

Cloud-basierte Plattformen wie AnyLogic revolutionieren die Umsetzung. Echtzeit-Simulationen laufen heute auf Standard-Hardware – dank optimierter Parallelverarbeitung. Drei entscheidende Fortschritte:

| Methoden | Vorteile | Anwendungsbereich |

|---|---|---|

| Neuronale Netze | Selbstoptimierende Modelle | Produktionsplanung |

| Monte-Carlo-Simulation | Risikominimierung | Finanzprognosen |

| Agentenbasierte Ansätze | Interaktionsanalyse | Logistiknetzwerke |

Unternehmen nutzen diese Software-Lösungen, um digitale Zwillinge zu erstellen. Ein Maschinenbauer reduzierte Testdurchläufe von 14 Tagen auf 8 Stunden – durch interaktive Lernmaterialien und skalierbare Rechenressourcen. Der Schlüssel liegt in der intelligenten Kombination aus Fachwissen und Technologie.

Planung und Umsetzung von virtuellen Testszenarien

Die Kunst virtueller Tests liegt in der präzisen Nachbildung realer Bedingungen. Wir zeigen, wie Sie theoretische Modelle in praxistaugliche Lösungen verwandeln – Schritt für Schritt und messbar.

Erstellung realistischer Szenarien und Parameterfestlegung

Beginnen Sie mit historischen Daten als Fundament. Ein Automobilzulieferer analysierte 12 Monate Produktionsprotokolle, um Materialflüsse zu optimieren. Wichtige Parameter:

- Zeitliche Schwankungen (Schichtbetrieb, Lieferzeiten)

- Ressourcenverbrauch pro Einheit

- Kritische Fehlerquellen aus vergangenen Projekten

Moderne Tools wie Simio helfen bei der Skalierung. Sie übersetzen Excel-Daten automatisch in 3D-Modelle. So entstehen dynamische Simulationen, die sich bei neuen Erkenntnissen selbst aktualisieren.

Best Practices und praktische Tipps

Erfolgreiche Projekte folgen vier Prinzipien:

- Testumfang schrittweise erhöhen (80/20-Regel)

- Sensordaten mit Expertenwissen kombinieren

- Ergebnisse visuell aufbereiten (Dashboards)

- Modelle quartalsweise überprüfen

Ein Logistikdienstleister reduziert so Fehldispositionen um 41%. Der Schlüssel? Kontinuierliches Lernen aus jeder Simulation. Je öfter Systeme laufen, desto präziser werden ihre Prognosen.

Nutzen Sie Pilotphasen clever: Beginnen Sie mit überschaubaren Teilbereichen. Sammeln Sie Erfolge, bevor Sie Gesamtprozesse digital abbilden. So minimieren Sie Risiken und gewinnen gleichzeitig Überzeuger im Team.

Datenanalyse und Qualitätsmanagement in Simulationen

Erfolgreiche Simulationen entstehen nicht durch Zufall – sie basieren auf präzisen Daten. Wir zeigen, wie Sie Rohinformationen in strategische Erkenntnisse verwandeln. Der Schlüssel liegt in systematischer Aufbereitung und intelligenter Validierung.

Vom Rohdatensatz zum belastbaren Modell

Qualität beginnt bei der Auswahl relevanter Datenquellen. Ein Automobilhersteller identifizierte durch systematische Filterung 38% überflüssige Sensormessungen. Drei kritische Schritte:

- Bereinigung: Fehlwerte und Ausreißer entfernen

- Transformation: Zeitreihen in maschinenlesbare Formate konvertieren

- Anreicherung: Externe Quellen wie Wetterdaten integrieren

Moderne Tools wie KI-gestützte Excel-Funktionen automatisieren diese Prozesse. Sie erkennen Muster in Millionen Datensätzen – manuell unmöglich.

Validierung sichert die Aussagekraft Ihrer Modelle. Vergleichen Sie Simulationsergebnisse mit realen Tests. Ein Logistikunternehmen entdeckte so Diskrepanzen bei Lieferzeiten und optimierte seine Algorithmen um 27%.

Große Datenmengen werden zum Vorteil, wenn Sie sie strategisch nutzen. Neuronale Netze filtern automatisch irrelevante Parameter. Das Ergebnis? Schnellere Analysen und präzisere Prognosen – selbst bei komplexen Szenarien.

Industrieanwendungen und Praxisbeispiele

Konkrete Beispiele aus der Industrie beweisen den Nutzen digitaler Lösungen. Wir zeigen, wie Unternehmen durch smarte Datenverarbeitung messbare Erfolge erzielen – von reduzierten Kosten bis hin zu schnelleren Innovationszyklen.

Fallstudie: Optimierung in der Logistik

Ein europäischer Logistikanbieter senkte seine Treibstoffkosten um 19% durch KI-gestützte Simulationen. Das System analysierte historische Routendaten und prognostizierte Engpässe vorab. Ergebnisse:

- Dynamische Anpassung von 12.000 Liefertouren monatlich

- Automatisierte Bestandsnachschub-Steuerung

- Reduktion von Überstunden im Dispositionsbereich um 31%

Praktische Anwendungsfälle in der Fertigung und Entwicklung

In der Automobilbranche optimieren lernfähige Systeme Produktionslinien. Ein Hersteller verkürzte Testphasen neuer Modelle von 11 auf 3 Wochen. Schlüsselfaktoren:

- Echtzeit-Analyse von 56 Qualitätsparametern

- Selbstkorrigierende Montageprozesse

- Digitale Zwillinge für 93% aller Komponenten

Die Zusammenarbeit zwischen Forschung und Praxis treibt diese Entwicklungen voran. Universitätsprojekte liefern Algorithmen, die Unternehmen in skalierbare Lösungen umwandeln. So entstehen anpassungsfähige Systeme, die sich ständig verbessern – ein Kreislauf aus Innovation und Umsetzung.

Integration in Unternehmensprozesse und IT-Strategien

Die erfolgreiche Integration digitaler Lösungen beginnt mit einer Brücke zwischen Theorie und Praxis. Unternehmen profitieren am meisten, wenn sie intelligente Systeme direkt in ihre Kernprozesse einbetten – von der Supply Chain bis zum Kundenservice.

Synergien für nachhaltige Lösungen

Forschungseinrichtungen liefern Algorithmen, die Industrie bringt reale Daten ein. Ein Beispiel: Ein Maschinenbauunternehmen optimierte seine Wartungsintervalle um 45%, indem es Universitätsforschung mit eigenen Produktionsdaten kombinierte. So entstehen maßgeschneiderte Anwendungen, die genau passen.

Drei Erfolgsfaktoren für die Zusammenarbeit:

- Gemeinsame Zieldefinition zwischen IT-Abteilung und Forschungsteams

- Agile Testphasen mit schnellen Feedbackschleifen

- Datenpools, die sowohl Privacy-Richtlinien als auch Forschungsbedürfnisse erfüllen

Ein Logistikdienstleister zeigt, wie es geht: Durch Partnerschaften mit Hochschulen entwickelte er ein selbstlernendes Routenplanungstool. Die Zusammenarbeit reduzierte Implementierungskosten um 32% und steigerte die Lieferpünktlichkeit.

Nutzen Sie diese Strategie: Starten Sie mit Pilotprojekten, die klare ROI-Ziele haben. Schulen Sie Mitarbeiter in interdisziplinären Workshops – so verbinden Sie technisches Know-how mit Betriebserfahrung. Die Zukunft gehört Unternehmen, die Wissenschaft und Praxis als Einheit denken.

Fazit

Die Zukunft industrieller Prozesse gestaltet sich durch intelligente Lösungen neu. Unternehmen, die auf moderne Simulationsverfahren setzen, sichern sich entscheidende Wettbewerbsvorteile – von reduzierten Kosten bis hin zu agileren Entscheidungsstrukturen.

Der gezielte Einsatz lernfähiger Systeme ermöglicht nachhaltige Verbesserungen. Durch die Analyse großer Datenmengen identifizieren Algorithmen Optimierungspotenziale, die menschliche Teams übersehen. Dieser Ansatz revolutioniert die Praxis: Aus theoretischen Modellen werden handfeste Ergebnisse.

Die Technologie birgt enormes Potenzial für alle Branchen. Wer heute in skalierbare Lösungen investiert, gestaltet morgen die Regeln des Marktes mit. Der Schlüssel liegt im Einsatz adaptiver Tools, die Theorie und Anwendung verbinden.

Startpunkt ist ein mutiger erster Schritt – testen Sie die Möglichkeiten. Die Zukunft gehört denen, die Daten strategisch nutzen und Innovationen mutig umsetzen.