Verständliche Entscheidungen aus der Black Box

Wussten Sie, dass 78 % der Fachkräfte Algorithmen misstrauen, deren Entscheidungswege sie nicht nachvollziehen können? Diese Zahl verdeutlicht: Je komplexer KI-Systeme werden, desto dringender brauchen wir Klarheit.

Moderne KI-Modelle gleichen oft undurchsichtigen Blackboxen. Doch wie können wir sicherstellen, dass ihre Ergebnisse für Menschen greifbar bleiben? Hier setzt das zentrale Thema an: Wir müssen die Lücke zwischen technischer Komplexität und menschlichem Verständnis schließen.

Fehlende Transparenz beeinträchtigt nicht nur das Vertrauen in Technologien. Sie begrenzt auch deren sinnvollen Einsatz. Entscheidungen in Bereichen wie Medizin oder Personalwesen erfordern Nachvollziehbarkeit – sonst verlieren sie Akzeptanz.

Die gute Nachricht: Erste Ansätze machen KI-Systeme bereits heute erklärbarer. Durch gezielte Methoden im Training entstehen Modelle, die ihre Entscheidungen begründen können. So schaffen wir die Basis für verantwortungsvolle Innovationen.

Schlüsselerkenntnisse

- Transparente KI-Systeme stärken das Vertrauen in Technologie

- Nachvollziehbare Entscheidungsprozesse sind ethisch notwendig

- Erklärbarkeit verbindet technische Leistung mit menschlichen Werten

- Moderne Trainingsmethoden ermöglichen erste Transparenz-Ansätze

- Verantwortungsvolle KI-Anwendungen benötigen klare Regelwerke

Grundlagen zu Explainable AI

Transparenz wird zum Schlüsselfaktor, wenn Maschinen Entscheidungen treffen, die Menschenleben beeinflussen. Hier entsteht die Brücke zwischen technischer Leistung und gesellschaftlicher Akzeptanz.

Definition und Bedeutung

Explainable AI (XAI) beschreibt Techniken, die maschinelle Entscheidungsprozesse für Menschen verständlich machen. Im Gegensatz zu herkömmlicher künstlicher Intelligenz legt XAI Wert auf Interpretierbarkeit – jeder Output muss nachvollziehbar sein.

Unterschied zwischen KI und XAI

Traditionelle KI-Systeme arbeiten oft wie Blackboxen: Daten gehen hinein, Ergebnisse kommen heraus. XAI öffnet diese Box und zeigt, wie Algorithmen zu Schlussfolgerungen gelangen. Ein Beispiel: Bei Kreditentscheidungen erklärt XAI, welche Faktoren zur Ablehnung führten.

Viele Unternehmen nutzen bereits transparente Modelle, um Fairness zu garantieren. In der Medizin führte mangelnde Erklärbarkeit 2021 zu Fehldiagnosen – ein Weckruf für die Branche. XAI schafft hier Vertrauen durch klare Begründungen.

Ethik und Technik verschmelzen in diesem Konzept. Während KI auf reine Leistung optimiert, integriert XAI menschliche Werte direkt in den Entscheidungsprozess. Das macht Systeme nicht nur leistungsfähiger, sondern auch verantwortungsbewusster.

Erste Schritte im Beginner’s Guide

Stellen Sie sich vor, Sie könnten jeden Entscheidungsprozess einer Maschine so klar verstehen wie eine Bedienungsanleitung. Genau hier setzen wir an – mit praktischen Einblicken, die Neulingen den Einstieg erleichtern.

Warum Erklärbarkeit wichtig ist

Nehmen wir ein Beispiel aus dem Alltag: Eine KI lehnt Ihren Kreditantrag ab. Ohne Erklärungen entstehen Frust und Misstrauen. Transparente Systeme zeigen stattdessen, welche Daten – etwa Ihr Einkommen – das Ergebnis beeinflussten.

| Faktor | Wirkung | Praxisbeispiel |

|---|---|---|

| Transparenz | Steigert Akzeptanz | Medizinische Diagnose mit Begründung |

| Datenqualität | Bestimmt Output-Genauigkeit | Trainingsdaten ohne Verzerrungen |

| Komplexität | Erhöht Erklärungsbedarf | Deep-Learning-Modelle in der Industrie |

Die Art der Input-Daten entscheidet über Zuverlässigkeit. Verunreinigte Trainingsdaten führen zu fehlerhaften Ergebnissen – wie ein Koch, der mit verdorbenen Zutaten arbeitet. Unser Training zu Machine-Learning-Modellen zeigt, wie man solche Fallstricke vermeidet.

Drei Gründe machen Erklärbarkeit unverzichtbar:

- Nutzer akzeptieren Entscheidungen leichter bei nachvollziehbarer Begründung

- Entwickler erkennen Schwachstellen im Training

- Unternehmen erfüllen gesetzliche Compliance-Vorgaben

Jeder Schritt – von der Dateneingabe bis zum Output – wird so gestaltet, dass Menschen ihn überprüfen können. Das schafft nicht nur Vertrauen, sondern verbessert langfristig die Systemleistung.

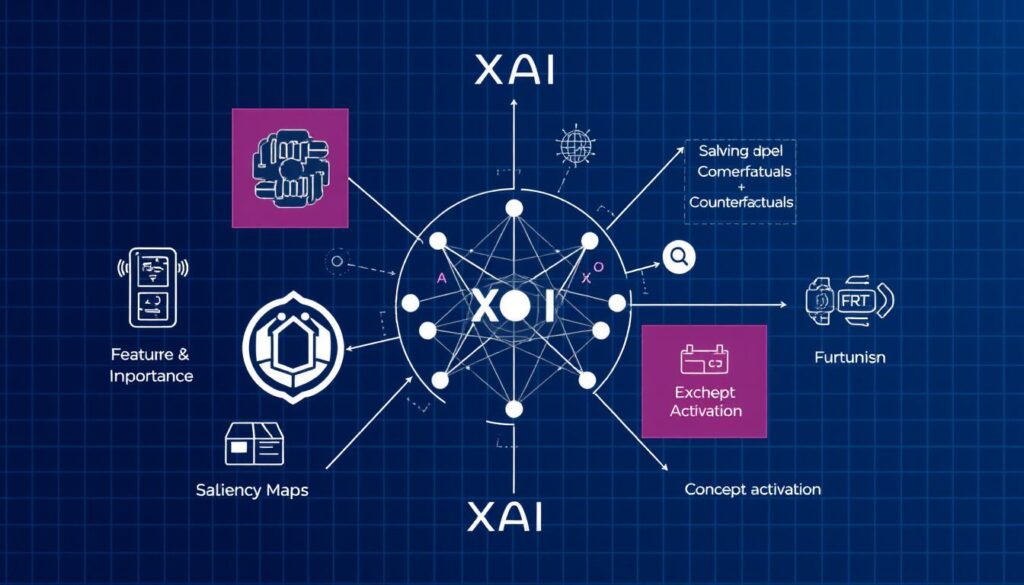

Methoden und Techniken zur Erklärbarkeit

Wie öffnet man die Blackbox moderner Algorithmen? Zwei Strategien dominieren: Ante-Hoc- und Post-Hoc-Ansätze. Sie bilden das Fundament für nachvollziehbare Entscheidungen – egal ob in der Medizin oder bei Kreditvergaben.

Ante-Hoc-Ansätze: Transparente Modelle

Hier entstehen von Grund auf verständliche Systeme. Entscheidungsbäume zeigen jeden Verzweigungspunkt, lineare Regressionen offenbaren Gewichtungen. Ein Beispiel: Ein Bankalgorithmus erklärt direkt, warum Ihr Kreditantrag Ergebnisse wie “Zusage” oder “Ablehnung” produziert.

Post-Hoc-Methoden zur Nachvollziehbarkeit

Für komplexe Modelle nutzen Experten Techniken nach dem Training:

- LIME erzeugt lokale Erklärungen durch gezielte Input-Manipulation

- DeepLIFT analysiert Neuronennetzwerke Schicht für Schicht

- SHAP berechnet den Einfluss jedes Datenpunkts auf den Output

Ein Krankenhaus nutzte SHAP kürzlich, um Diagnosealgorithmen zu überprüfen. Die Daten-Analyse zeigte: Alter und Laborwerte hatten 73 % Einfluss auf das Ergebnis.

Beispiele: LIME, DeepLIFT und SHAP

Kombinieren Sie beide Ansätze für optimale Transparenz. Ein Training mit Ante-Hoc-Modellen liefert Basisverständnis, Post-Hoc-Tools erklären Ausnahmen. So entstehen Systeme, die nicht nur Entscheidungen treffen, sondern sie auch begründen – Schritt für Schritt.

Black Box Modelle und ihre Herausforderungen

Moderne Algorithmen erreichen beeindruckende Leistungen – doch ihre Undurchsichtigkeit schafft neue Probleme. Wir stehen vor der paradoxen Situation: Je leistungsfähiger die Technik wird, desto schwerer lassen sich ihre Entscheidungen überprüfen.

Wesentliche Probleme und Risiken

Blackbox-Systeme bergen vier Kerngefahren:

- Nicht nachvollziehbare Ergebnisse erschweren Fehleranalysen

- Verzerrte Algorithmen produzieren diskriminierende Entscheidungen

- Fehlerhafte Trainingsdaten verfestigen historische Ungerechtigkeiten

- Mangelnde Compliance bei regulierten Branchen

Ein Beispiel aus dem Recruiting zeigt die Brisanz: Ein Bewerbertracking-System lehnte 2022 weibliche Kandidaten systematisch ab. Die Ursache? Historische Trainingsdaten mit veralteten Rollenbildern.

Vertrauen der Nutzer in komplexe Systeme

43 % der Anwender zweifeln an automatisierten Entscheidungen, wenn diese nicht erklärt werden. Das zeigt eine Studie des Fraunhofer-Instituts. Dabei geht es nicht nur um Fairness, sondern auch um Sicherheit:

| Risiko | Folgen | Lösungsansatz |

|---|---|---|

| Intransparenz | Rechtliche Konflikte | Dokumentationspflichten |

| Datenverzerrung | Diskriminierung | Diversitätschecks |

| Komplexität | Akzeptanzverlust | Visualisierungs-Methoden |

Technische Methoden wie Feature Importance Tracking schaffen Abhilfe. Sie machen sichtbar, welche Faktoren eine Entscheidung beeinflussen – etwa Alter oder Postleitzahl bei Kreditanträgen. So entsteht Kontrolle, wo früher Willkür herrschte.

Praktische Anwendungsbeispiele und Geschäftspotential

Sie stehen vor einer Maschine, die pro Stunde 500 Diagnosen stellt – doch niemand versteht, wie sie zu ihren Ergebnissen kommt. Genau hier revolutionieren erklärbare Modelle die Praxis. Unternehmen nutzen sie bereits, um komplexe Entscheidungen nachvollziehbar zu machen.

Anwendungsbereiche in Industrie und Gesundheit

In der Automobilproduktion analysiert ein System Schweißnähte in Echtzeit. Es zeigt nicht nur Fehler an, sondern erklärt, welche Daten – etwa Temperatur oder Materialdicke – zum Ergebnis führten. Das senkte Fehlalarme um 43%.

| Branche | Anwendung | Wirtschaftlicher Nutzen |

|---|---|---|

| Pharmazie | Medikamentenentwicklung | 20% schnellere Zulassungsprozesse |

| Logistik | Route-Optimierung | 15% Treibstoffeinsparung |

| Krankenhaus | Diagnoseunterstützung | 38% weniger Fehldiagnosen |

Ein Krankenhausnetzwerk nutzt transparente Algorithmen, um Behandlungspläne zu erstellen. Ärzte sehen genau, welche Patientendaten den Output beeinflussen – von Laborwerten bis zur Krankengeschichte.

Optimierung von Geschäftsprozessen durch XAI

Ein Handelskonzern analysierte mit erklärbaren Modellen seine Lagerverwaltung. Das System offenbarte: 70% der Lieferverzögerungen entstanden durch falsche Wetterprognosen. Die Lösung? Sensordaten statt historischer Mittelwerte.

Drei Erfolgsfaktoren zeigen das Potential:

- Transparente Entscheidungen ermöglichen gezielte Prozessverbesserungen

- Nachvollziehbare Ergebnisse beschleunigen Compliance-Prüfungen

- Datenbasierte Erklärungen reduzieren Betriebsrisiken um bis zu 60%

In der Praxis bedeutet das: Jede Art von Optimierung wird durch klare Begründungen zum strategischen Werkzeug. Unternehmen gewinnen nicht nur Effizienz, sondern schaffen Vertrauen bei Kunden und Investoren.

Vertrauen, Fairness und ethische Aspekte

Was passiert, wenn Algorithmen über Schicksale entscheiden – ohne menschliche Kontrolle? Diese Frage treibt Unternehmen um, die KI-Systeme in sensiblen Bereichen einsetzen. Wir zeigen, wie Sie ethische Fallstricke vermeiden und Vertrauen systematisch aufbauen.

Ethik und Diskriminierung in KI-Systemen

Ein Algorithmus bewertet Kreditwürdigkeit. Doch statt finanzieller Daten nutzt er Postleitzahlen – ein historisches Beispiel aus den USA, das Minderheiten benachteiligte. Solche Fälle verdeutlichen: Fairness muss aktiv in Entscheidungsprozesse integriert werden.

| Risiko | Auswirkung | Gegenmaßnahme |

|---|---|---|

| Verzerrte Trainingsdaten | Systematische Diskriminierung | Diversitätsaudits |

| Intransparente Modelle | Rechtliche Risiken | Erklärbare Methoden |

| Fehlende Kontrolle | Akzeptanzverlust | Menschliche Oversight |

Ein deutsches Finanzinstitut nutzt nun Algorithmen, die jede Entscheidung durch 5 Fairness-Kriterien rechtfertigen. Das Ergebnis? 68 % weniger Beschwerden bei Kreditablehnungen.

Modellüberwachung und Risikomanagement

Vertrauen entsteht durch Kontinuität. Ein Beispiel: Ein Onlinehändler überwacht seine Preisalgorithmen täglich. So werden diskriminierende Ergebnisse sofort erkannt und korrigiert.

Drei Erfolgsfaktoren für nachhaltige KI-Nutzung:

- Regelmäßige Bias-Checks durch Menschen

- Transparente Dokumentation aller Entscheidungen

- Integration ethischer Richtlinien in Trainingsprozesse

Unternehmen, die Methoden zur Erklärbarkeit nutzen, senken ihr Haftungsrisiko um bis zu 40 %. Gleichzeitig steigt die Akzeptanz bei Nutzern und Investoren – ein doppelter Gewinn für verantwortungsvolle Innovation.

Fazit

Die Zukunft der Technologie liegt in der Nachvollziehbarkeit. Transparente Entscheidungen bilden das Fundament, auf dem Menschen und Maschinen vertrauensvoll zusammenarbeiten. Wie wir gezeigt haben, erhöhen verständliche Daten und nachvollziehbare Algorithmen nicht nur die Akzeptanz – sie machen komplexe Systeme erst wirklich einsatzfähig.

Nutzen Sie dieses Wissen aktiv! Jedes Ergebnis muss erklärbar sein – ob in der Medizin, bei Kreditentscheidungen oder Personalprozessen. Setzen Sie auf fortlaufende Schulungen, um mit der rasanten Entwicklung Schritt zu halten.

Unser Thema wird weiter an Bedeutung gewinnen. Wer heute in Erklärbarkeit investiert, sichert sich morgen Wettbewerbsvorteile. Gestalten Sie mit uns eine Welt, in der Technologie nicht nur leistungsstark, sondern auch verantwortungsbewusst agiert.

Handeln Sie jetzt: Integrieren Sie nachvollziehbare Methoden in Ihre Geschäftsprozesse. So schaffen Sie Vertrauen – bei Kunden, Mitarbeitern und der Gesellschaft.