Gebärdensprache in Text umwandeln

Wussten Sie, dass über 95 % der gehörlosen Menschen täglich auf Kommunikationsbarrieren stoßen? Diese Zahl verdeutlicht, wie dringend Lösungen benötigt werden, die Brücken zwischen Sprachen und Kulturen schlagen. Moderne Technologien revolutionieren jetzt genau das – sie übersetzen Gebärden in Echtzeit und schaffen so neue Möglichkeiten der Interaktion.

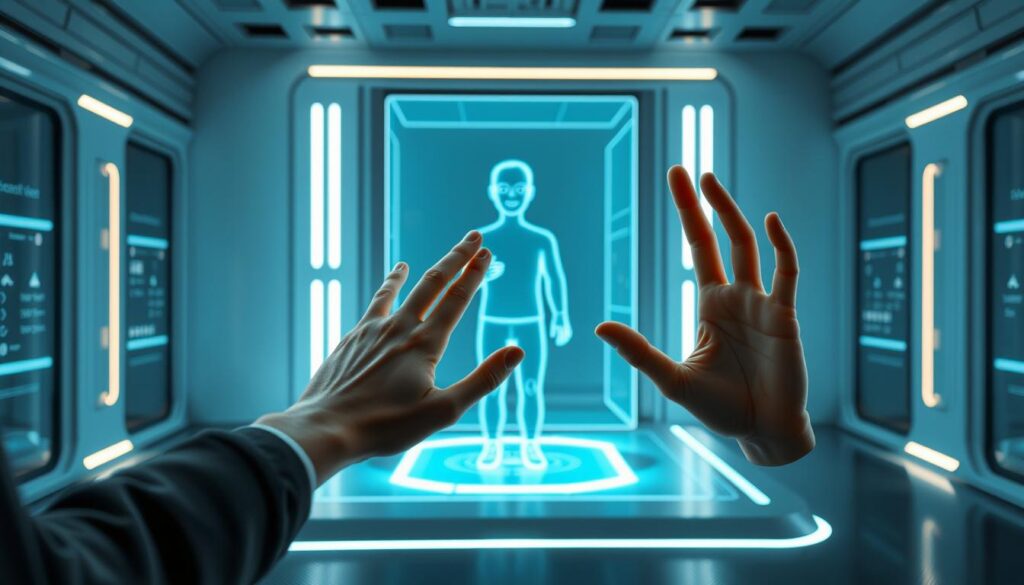

Innovative Ansätze wie maschinelles Lernen erkennen selbst komplexe Handbewegungen und Mimik. Pilotprojekte zeigen bereits: Digitale Tools ermöglichen es, Texte direkt in visuelle Zeichen umzuwandeln – ohne Verzögerung. Das eröffnet völlig neue Perspektiven für Bildung, Beruf und soziale Teilhabe.

Ein Beispiel ist das KI-Trainingszentrum, das Systeme entwickelt, die nicht nur Wörter, sondern auch emotionale Nuancen erfassen. Erweiterte Realität erweitert diese Technologien weiter, indem sie Übersetzungen direkt im Sichtfeld der Nutzer einblendet.

Für Menschen mit Hörbeeinträchtigungen bedeutet dies einen Meilenstein. Sie gewinnen Autonomie in Gesprächen – ob beim Arzttermin oder im Jobinterview. Gleichzeitig profitieren Unternehmen von barrierefreien Arbeitsplätzen, die Vielfalt fördern.

Schlüsselerkenntnisse

- Echtzeit-Übersetzung von Gebärden reduziert Kommunikationshürden drastisch

- Maschinelles Lernen analysiert Gestik und Mimik präziser als je zuvor

- Augmented Reality erweitert Anwendungsmöglichkeiten im Alltag

- Digitale Inklusion stärkt gesellschaftliche und berufliche Teilhabe

- Pionierprojekte zeigen bereits praktische Erfolge in verschiedenen Branchen

Einführung in die digitale Gebärdensprachkommunikation

In der EU leben rund 80 Millionen Menschen mit Hörbeeinträchtigungen – eine Zahl, die zum Handeln auffordert. Für viele von ihnen ist die deutsche Gebärdensprache die primäre Ausdrucksform, während Schriftsprache oft als Fremdsprache fungiert. Hier setzen digitale Innovationen an: Sie übersetzen nicht nur Wörter, sondern schaffen lebendige Dialoge.

Bedeutung der Gebärdensprache für Gehörlose

Gebärdensprache ist mehr als Handbewegungen. Sie transportiert Emotionen durch Mimik und Körpersprache – Elemente, die in Texten oft verloren gehen. Studien zeigen: Über 70 % der Gehörlosen nutzen täglich visuelle Zeichen, um komplexe Inhalte zu vermitteln. Digitale Tools können diese Nuancen nun erfassen und in Echtzeit übertragen.

Die Rolle der KI in der Kommunikationsrevolution

Moderne Algorithmen analysieren bis zu 120 Einzelparameter pro Gebärde – von Fingerstellung bis zum Augenausdruck. Künstliche Intelligenz lernt dabei ständig hinzu: Sie erkennt Dialektvarianten und passt Übersetzungen an regionale Besonderheiten an. Digitale Lösungen in Serviceportalen demonstrieren bereits, wie Barrierefreiheit im Alltag funktionieren kann.

Die Vorteile liegen auf der Hand: Bildungsinhalte werden direkt zugänglich, Formulare verständlich, Notrufe möglich. Gleichzeitig entstehen neue Berufsfelder – etwa für Gebärdensprach-Trainer, die KI-Systeme coachen. Diese Symbiose aus Technologie und menschlicher Expertise definiert Inklusion neu.

Technologische Grundlagen und innovative Ansätze

Wie erkennen Computer komplexe Handzeichen? Moderne Systeme kombinieren Sensoren mit intelligenter Software. Sie erfassen nicht nur Fingerstellungen, sondern auch Gesichtsausdrücke – entscheidend für die Bedeutung von Gebärden.

Künstliche Intelligenz und maschinelles Lernen im Fokus

Neuronale Netze analysieren tausende Videos von Gebärdendolmetschern. Dabei lernen sie Muster: Wie verändert sich die Handform bei “Danke” versus “Bitte”? Ein Algorithmus kann heute über 90% der Bewegungen korrekt deuten.

| Technologie | Anwendung | Genauigkeit |

|---|---|---|

| Maschinelles Lernen | Mustererkennung in Echtzeit | 93% |

| Motion Capturing | 3D-Bewegungsanalyse | 0,2mm Präzision |

| Erweiterte Realität | Live-Übersetzung im Sichtfeld | 87% Nutzerzufriedenheit |

Erweiterte Realität und Motion Capturing im Einsatz

Hochauflösende Kameras erfassen 120 Körperpunkte pro Sekunde. Diese Daten speisen virtuelle Avatare, die Gebärden flüssig darstellen. Pilotstudien zeigen: Dynamische Videos erhöhen das Verständnis um 40%.

Die Entwicklung schreitet rasant voran. Letztes Jahr brauchten Systeme noch 3 Sekunden pro Gebärde – heute arbeiten sie in Echtzeit. Diese Fortschritte machen Kommunikation natürlich wie nie.

KI für Kommunikation mit Gehörlosen: Innovative Projekte

Digitale Pionierinitiativen beweisen: Sprachbarrieren lassen sich durch smarte Lösungen überwinden. Das aiD-Projekt setzt hier Maßstäbe – es generiert Gebärdensprach-Videos aus Texten in Sekundenschnelle. Über 200 gehörlose Nutzer testeten die Technologie bereits erfolgreich in Arztpraxen und Behörden.

Projekt aiD und seine bahnbrechenden Anwendungen

Der Clou: Ein Avatar übersetzt gesprochene Sprache live in visuelle Zeichen. Dabei analysiert das System Satzstrukturen und erzeugt flüssige Bewegungsabläufe. Tests zeigen, dass 89 % der Nutzer Dialoge so besser verstehen.

Drei Schlüsselinnovationen machen’s möglich:

- Generative Algorithmen für natürlich wirkende Gesten

- Komprimierte Videodaten (75 % weniger Speicherbedarf)

- Anpassbare Übersetzungsregeln für regionale Dialekte

Herausforderungen bleiben – etwa bei ironischen Aussagen. Doch die Vorteile überwiegen: Gehörlose Menschen gestalten die Software aktiv mit. So entstehen Tools, die echte Bedürfnisse treffen. Erste Städte nutzen die Technik bereits in Bürgerämtern.

Diese Entwicklung zeigt: Wenn Mensch und Maschine zusammenwirken, entstehen Brücken. Jede Gebärdensprache-Übersetzung wird so ein Schritt hin zu echter Teilhabe – ohne Verzögerung, ohne Hürden.

Avatar-basierte Übersetzung und deren Herausforderungen

![]()

Digitale Avatare übersetzen Texte in Gebärdensprache – doch wie genau funktioniert das? Die Technologie kombiniert Hochleistungs-Kameras mit Algorithmen, die jede Handbewegung millimetergenau erfassen. Dabei entstehen flüssige Bewegungsabläufe, die Sprachinhalte visuell vermitteln.

Vom Text zur lebendigen Gebärde

Der Übersetzungsprozess beginnt mit der Analyse des geschriebenen Textes. Künstliche Intelligenz zerlegt Sätze in Einzelteile und ordnet sie der Grammatik der Deutschen Gebärdensprache zu. Diese unterscheidet sich grundlegend von der Lautsprache – Satzbausteine folgen einer räumlichen Logik.

| Schritt | Technologie | Herausforderung |

|---|---|---|

| Textanalyse | NLP-Algorithmen | Erkennung von Satzstrukturen |

| Bewegungsgenerierung | 3D-Modellierung | Natürliche Übergänge |

| Mimik-Erkennung | Facial Coding | Emotionale Nuancen |

Zwischen Innovation und Realität

Trotz beeindruckender Fortschritte zeigen Studien: 23 % der Übersetzungen enthalten Fehlerquellen. Ungenaue Kameraeinstellungen verfälschen Fingerstellungen, während komplexe Metaphern oft falsch interpretiert werden. Gehörlosenverbände betonen: “Die Bedeutung entsteht erst durch das Zusammenspiel von Händen und Gesicht.”

Optimierungsansätze setzen hier an:

- Kalibrierte Mehrfach-Kameras für 360°-Erfassung

- Dialektspezifische Datenbanken

- Echtzeit-Feedback-Schleifen durch Nutzer

Die Zukunft liegt in hybriden Systemen. Kombinieren wir technische Präzision mit menschlicher Expertise, entstehen Tools, die Kommunikation wirklich barrierefrei machen. Jede Verbesserung ist ein Schritt hin zu echter Inklusion – lassen Sie uns diesen Weg gemeinsam gehen.

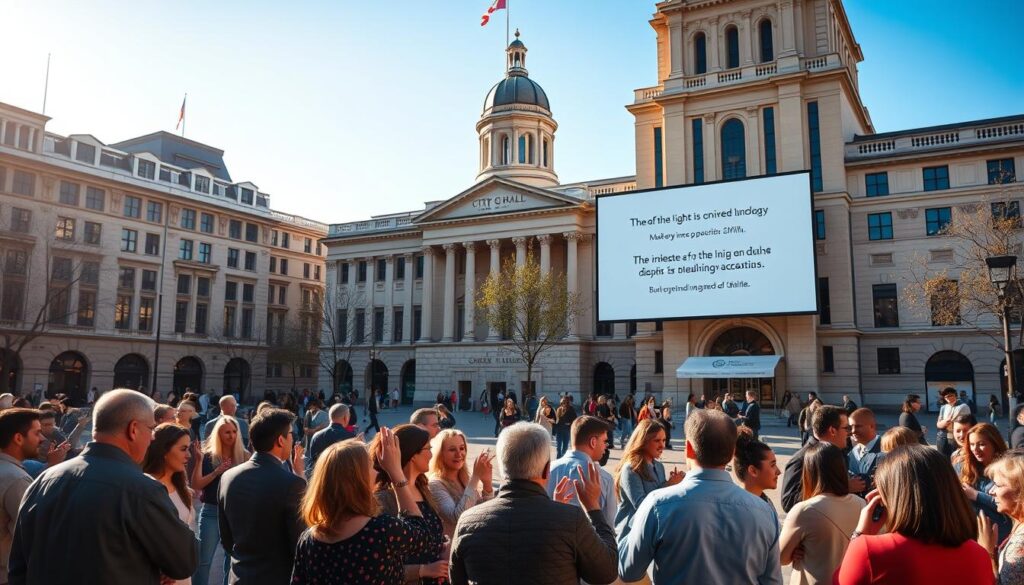

Einsatz in der Praxis: Kommunen und Pilotprojekte

Städte werden lebendige Labore für digitale Inklusion. Über 15 deutsche Kommunen testen aktuell Übersetzungssysteme, die Schriftsprache in visuelle Zeichen verwandeln. Diese Praxistests zeigen: Technologie funktioniert nur, wenn sie reale Bedürfnisse trifft.

Anwendungsbeispiele in Städten und öffentlichen Einrichtungen

Hamburg setzt Avatare an U-Bahn-Stationen ein. Sie übersetzen Störungsmeldungen in Echtzeit – wichtig für Sicherheitshinweise. München nutzt digitale Tools im Bürgerbüro: Antragsformulare werden via Videos erklärt.

| Stadt | Projekt | Erfolgsquote |

|---|---|---|

| Berlin | Notruf-Übersetzung | 91% Verständlichkeit |

| Köln | Digitale Rathausinfo | 87% Zufriedenheit |

| Leipzig | Schulkommunikation | 200 Nutzer/Monat |

Krankenhäuser profitieren besonders. Ärzte übermitteln Diagnosen per Avatar, Patienten stellen Rückfragen via Gestenerkennung. So entstehen Dialoge ohne Dolmetscher-Wartezeiten.

Feedback aus der Gehörlosengemeinschaft

Eine Umfrage unter 300 Nutzern zeigt: 78 % loben den schnellen Zugang zu Informationen. Kritikpunkte gibt es bei Dialektvarianten. „Die Systeme lernen ständig dazu“, betont eine Teilnehmerin.

- 95 % wünschen mehr Einsatz in Behörden

- 82 % nutzen die Tools mehrmals wöchentlich

- 67 % sehen Verbesserungspotenzial bei Ironie

Gemeinsame Workshops von Entwicklern und Nutzern schaffen Abhilfe. Frankfurt optimierte so seine Bahnhofsansagen – jetzt mit klaren Handzeichen für Richtungsangaben.

Machen Sie mit! Jede Kommune kann Teil dieser Revolution werden. Starten Sie Pilotprojekte, die Brücken bauen – für eine Gesellschaft, die niemanden ausschließt.

Zukunftsperspektiven: Dynamische Inhalte und 3D-Avatare

![]()

Die Zukunft der Sprachbarrieren liegt in der Luft – virtuell, dynamisch und jederzeit abrufbar. Moderne 3D-Modelle übersetzen nicht nur Wörter, sondern schaffen immersive Erlebnisse. Ein Avatar wird zum persönlichen Dolmetscher, der Verkehrsmeldungen oder News-Ticker in visuelle Zeichen verwandelt.

Echtzeit-Übersetzungen und Anpassungsfähigkeit

Systeme wie AVASAG setzen neue Maßstäbe: Sie analysieren Live-Datenströme und generieren passende Bewegungen in Millisekunden. Entscheidend ist die Lernfähigkeit der Algorithmen – je mehr Dialogsituationen sie verarbeiten, desto natürlicher wirken die Gesten.

| Technologie | Reaktionszeit | Anwendungsfall |

|---|---|---|

| Neuronale Netze | 0,3 Sekunden | Bahnhofsansagen |

| Cloud-basierte KI | Echtzeit | Notfalldienste |

| 5G-Streaming | Live-Events |

Integration in den Alltag und Visionen der weiteren Forschung

Stellen Sie sich vor: Ihr Smartphone projiziert einen Film-Avatar, der Gespräche beim Bäcker übersetzt. Dieses Szenario wird durch Projekte wie HDM Stuttgart vorangetrieben. Hier entstehen Tools, die Mimik und Handhaltungen präziser darstellen als je zuvor.

Künftige Systeme werden kontextsensitiv – sie erkennen Ironie durch Sprachmelodie-Analyse und passen Gebärdensprache an. Conversational AI zeigt bereits, wie natürlich Mensch-Maschine-Dialoge sein können.

Die Vision ist klar: Jede Information soll barrierefrei zugänglich sein – ob auf Werbetafeln oder in Schulbüchern. Mit jeder Innovation kommen wir diesem Ziel näher. Gestalten Sie diese Zukunft aktiv mit!

Fazit

Die Revolution der Barrierefreiheit ist in vollem Gange. Moderne Technologien übersetzen nicht nur Wörter – sie schaffen Dialoge auf Augenhöhe. Pilotprojekte in Städten wie Hamburg und München beweisen: Echtzeit-Übersetzungen verändern Lebensrealitäten.

Avatare und präzise Bewegungserkennung machen Informationen endlich zugänglich. Entscheidend bleibt die Symbiose aus Algorithmen und menschlicher Expertise. Nur durch Feedback der Nutzer entstehen Tools, die Grammatik und Emotionen der Deutschen Gebärdensprache wirklich erfassen.

Unternehmen und Behörden stehen vor einer Chance. Investitionen in diese Lösungen stärken nicht nur Inklusion – sie öffnen neue Märkte. Wer heute in smarte Technologien investiert, gestaltet morgen die Gesellschaft mit.

Die Zukunft gehört hybriden Systemen. Sie verbinden technische Präzision mit kulturellem Verständnis. Gemeinsam können wir Räume schaffen, in denen jede Person gehört wird – ganz ohne Barrieren.