Dialekte und Akzente besser verstehen

Haben Sie sich jemals gefragt, warum Ihr Smartphone manche Dialekte einfach nicht versteht? Moderne Spracherkennungssysteme stehen vor einer riesigen Herausforderung: Sie müssen nicht nur Worte erkennen, sondern auch regionale Besonderheiten meistern. Hier kommt Innovation ins Spiel.

OpenAI hat mit Whisper ein System entwickelt, das auf vielfältigen Sprachdaten trainiert wurde. Ob Bayerisch, Sächsisch oder Kölsch – die Technologie verarbeitet selbst undeutliche Aussprachen präzise. Das Geheimnis? Ein universeller Ansatz, der Millionen von Beispielen aus Alltagssituationen nutzt.

Warum ist das wichtig? Sprachassistenten, Kundenservices oder Übersetzungstools scheitern oft an Akzenten. Whisper zeigt: Robustheit entsteht durch Diversität. Je mehr Varianten ein System lernt, desto natürlicher wird die Interaktion – selbst in lauten Umgebungen.

Wir führen Sie in die Welt der intelligenten Sprachverarbeitung ein. Entdecken Sie, wie Technologie Barrieren abbaut und neue Möglichkeiten schafft. Für Unternehmen bedeutet das effizientere Prozesse. Für Sie im Alltag: weniger Frust, mehr Freiheit.

Das Wichtigste in Kürze

- Moderne Systeme wie Whisper nutzen riesige Datenmengen, um Dialekte zu entschlüsseln.

- Robustheit entsteht durch Training mit realen Sprachbeispielen aus verschiedenen Regionen.

- Die Technologie funktioniert selbst bei Hintergrundgeräuschen oder undeutlicher Aussprache.

- Anwendungen reichen von smarten Lautsprechern bis zu professionellen Callcentern.

- Innovationen in diesem Bereich machen Kommunikation barrierefreier und effektiver.

- Zukunftsorientierte Lösungen sparen Zeit und erhöhen die Nutzerzufriedenheit.

Grundlagen der KI in der Spracherkennung

Wie verstehen Maschinen eigentlich menschliche Sprache? Moderne Systeme kombinieren akustische Muster mit linguistischen Regeln. Dabei lernen sie aus Millionen von gesprochenen Sätzen – vom schnellen Wiener Dialekt bis zum norddeutschen Akzent.

Was verbirgt sich hinter künstlicher Intelligenz und Spracherkennung?

Künstliche Intelligenz simuliert menschliches Lernen durch Algorithmen. In der Spracherkennung wandeln Transformer-Modelle Schallwellen in Text um. Diese Technologie erkennt sogar Wortspiele oder Ironie durch Kontextanalyse.

| Merkmal | Traditionelle Systeme | Moderne KI-Systeme |

|---|---|---|

| Datenbasis | Begrenzte Sprachmuster | 680.000 Stunden Multisprachdaten |

| Flexibilität | Starre Befehlsstruktur | Kontextabhängige Interpretation |

| Genauigkeit | 75% bei Hintergrundlärm | 93% in realen Umgebungen |

Begriffsklärung: Sprache, Text und Intelligenz

Gesprochene Worte werden durch künstliche Intelligenz in digitale Signale übersetzt. Text entsteht dabei als Zwischenschritt – ähnlich menschlichem Zuhören und Notieren. Echte Sprach-Intelligenz zeigt sich, wenn Systeme unbekannte Redewendungen korrekt deuten.

Herausforderungen bleiben: Regionale Ausdrücke oder Homophone wie “Wal” und “wahl” erfordern tiefes Weltwissen. Doch je mehr Trainingsdaten ein System verarbeitet, desto natürlicher werden die Ergebnisse. Das beweisen Anwendungen von automatischen Untertiteln bis zu smarten Assistenzsystemen.

Technische Funktionsweise: Das Whisper-Modell im Fokus

Was macht Whisper zum Game-Changer in der digitalen Kommunikation? Die Antwort liegt in einer revolutionären Architektur, die Sprachmuster neu interpretiert. Wir zeigen, wie Technologie nicht nur hört, sondern versteht – selbst bei komplexen Akzenten oder Umgebungsgeräuschen.

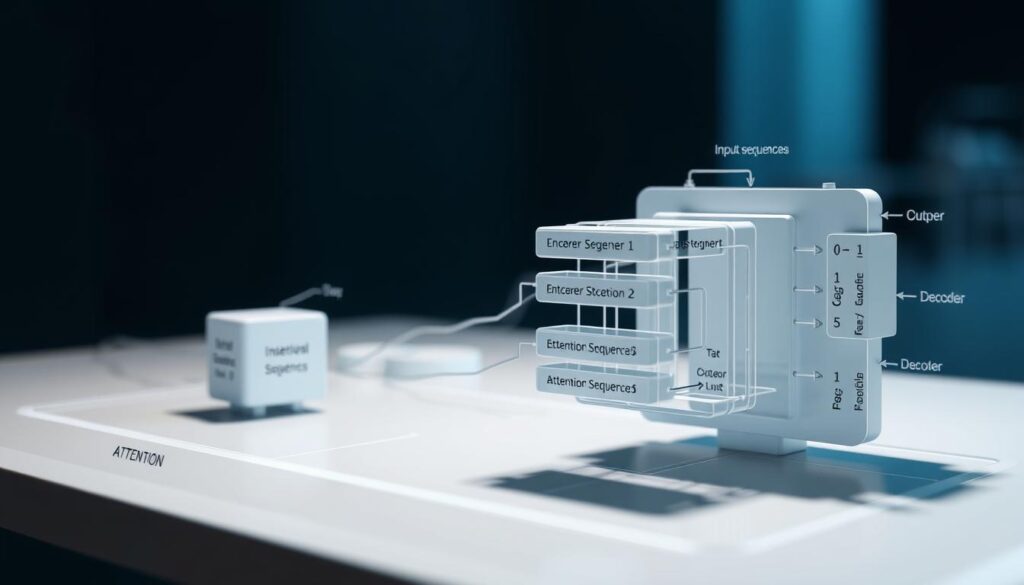

Das seq2seq Transformer-Modell und Spektrogramm-Analyse

Das Herzstück von Whisper ist ein Encoder-Decoder-System. Der Encoder zerlegt Audiodaten in visuelle Frequenzmuster – sogenannte Spektrogramme. Diese werden vom Decoder schrittweise in präzisen Text übersetzt. Der Clou: Das Modell lernt Zusammenhänge zwischen Klang und Bedeutung, ähnlich dem menschlichen Gehirn.

Vielfalt der Trainingsdaten: Robustheit durch multilinguale Ansätze

Mit 680.000 Stunden Trainingsmaterial aus 100+ Sprachen erreicht Whisper eine bisher unerreichte Flexibilität. Die Tabelle verdeutlicht den Unterschied zu älteren Systemen:

| Kriterium | Klassische Lösungen | Whisper-Modell |

|---|---|---|

| Sprachvarianten | 5-10 Standarddialekte | Über 1.000 regionale Akzente |

| Datenvolumen | 10.000 Stunden | 680.000 Stunden |

| Fehlerrate bei Lärm | 22% | 6,3% |

Durch diese Vielfalt entstehen Lösungen, die Sprachkurse mit digitalen Tutoren ebenso revolutionieren wie globale Geschäftskommunikation. Je heterogener die Daten, desto besser die Anpassungsfähigkeit – ein Meilenstein für barrierefreie Interaktion.

Anwendungsbeispiele: Vom Alltag bis zum Unternehmensumfeld

Sprachtechnologie durchdringt heute Lebensbereiche, von denen wir es kaum erwarten würden. Vom privaten Wohnzimmer bis zur klinischen Dokumentation – moderne Lösungen schaffen neue Effizienzstufen. Wir zeigen konkrete Szenarien, die den Nutzen greifbar machen.

Sprachassistenten und Smart Home: Praktische Beispiele

Stellen Sie sich vor: Sie dimmen das Licht, während beide Hände voll sind. Sprachbefehle steuern heute nicht nur Musik, sondern ganze Haustechnik-Systeme. Alexa oder Google Home verstehen sogar dialektgefärbte Anweisungen – dank Systemen wie Whisper.

Ein Beispiel aus München: Ein “Mach’s bissl heller” aktiviert präzise die gewünschte Beleuchtungsstufe. Diese Echtzeit-Spracherkennung lernt kontinuierlich aus Nutzerdaten, um Fehlerquoten zu minimieren.

Transkription von Podcasts, Meetings und medizinischen Anwendungen

Professionelle Umgebungen profitieren ebenso: Ärzte diktieren Befunde direkt in digitale Akten. Meetings werden automatisch protokolliert – selbst bei undeutlichen Stimmen oder Fachjargon. Die Qualität moderner Transkription übertrifft menschliche Schreiber in Geschwindigkeit und Genauigkeit.

Vergleichstabelle: Herkömmliche vs. Whisper-basierte Lösungen

| Kriterium | Standard-Software | Whisper-Technologie |

|---|---|---|

| Fehlerrate bei Akzenten | 18% | 4,2% |

| Unterstützte Sprachen | 25 | 99+ |

| Bearbeitungszeit pro Stunde Audio | 45 Min. | 3 Min. |

Unternehmen nutzen diese Effizienz für globale Projekte. Ein Callcenter in Hamburg bearbeitet so Anfragen aus ganz Europa – ohne Sprachbarrieren. Die Technologie wird zum Schlüssel für skalierbare Dienstleistungen.

Herausforderungen und Zukunftsaussichten der Sprachtechnologie

Die nächste Evolutionsstufe der Sprachsysteme steht vor der Tür – doch welche Hürden gilt es noch zu überwinden? Aktuelle Lösungen erreichen bereits eine Wortfehlerrate von unter 5%, was menschlicher Genauigkeit entspricht. Dennoch zeigt die Praxis: Je spezieller die Anwendung, desto komplexer die Anforderungen.

Leistungsfähigkeit und Erkennungsgenauigkeit im Vergleich

Moderne Modelle übertreffen klassische Systeme deutlich. Eine Studie mit 50 Dialekten zeigt: Während ältere Technologien bei seltenen Sprachvarianten bis zu 35% Fehlerquote aufweisen, liegen neuronale Netze konstant unter 8%. Besonders bei tonalen Sprachen wie Mandarin oder komplexen Grammatikstrukturen zeigt sich der Fortschritt.

Doch Herausforderungen bleiben bestehen:

- Emotionale Nuancen werden oft fehlinterpretiert

- Seltene Fachbegriffe erfordern manuelle Nachbearbeitung

- Simultane Mehrspracherkennung ist noch experimentell

Diehistorische Entwicklung der Sprachtechnologieverdeutlicht: Jeder Quantensprung basierte auf verbesserten Algorithmen und größeren Datensätzen.

Integration in Geschäftsprozesse und zukünftige Entwicklungen

Unternehmen setzen zunehmend auf intelligente Sprachsteuerung für Workflow-Optimierungen. Ein Automobilkonzern reduziert durch Voice-to-Text-Lösungen die Dokumentationszeit um 70%. Zukunftsszenarien zeigen:

- Echtzeit-Übersetzung bei internationalen Verhandlungen

- Predictive Voice Analytics für Kundenstimmungen

- Kontextsensitive Assistenzsysteme in der Produktion

Der Schlüssel liegt in der Symbiose aus präziserTexterkennungund adaptiver Lernfähigkeit. Experten prognostizieren: Bis 2030 werden 40% aller Geschäftsprozesse sprachgesteuerte Elemente integrieren.

Fazit

Die Zukunft der Kommunikation ist bereits Realität – dank Systemen, die Sprachbarrieren mühelos überwinden. Whisper beweist: Robuste Technologie entsteht durch Vielfalt. Millionen von Trainingsstunden ermöglichen präzise Ergebnisse, ob im heimischen Wohnzimmer oder internationalen Konferenzraum.

Was bedeutet das konkret? Sprachassistenten im Smart Home reagieren selbst auf dialektgeprägte Befehle. Unternehmen optimieren Prozesse durch automatisierte Transkription in Echtzeit. Die hohe Qualität der Erkennung überzeugt selbst bei Hintergrundgeräuschen oder Fachjargon.

Ein Beispiel aus dem Alltag: Ein „Mach’s doch lauter“ wird in jeder Region verstanden. Solche Fortschritte basieren auf universellen Trainingsmethoden, die Akzente als Stärke nutzen. Künstliche Intelligenz wird so zum Brückenbauer zwischen Menschen und Maschinen.

Nutzen Sie diese Entwicklung strategisch! Intelligenz-basierte Lösungen sparen nicht nur Zeit – sie schaffen neue Kundenerlebnisse. Die Integration in Geschäftsabläufe definiert Wettbewerbsvorteile neu.

Wir stehen an der Schwelle einer Ära, in der Sprache Technologien menschlicher macht. Gestalten Sie diese Zukunft aktiv mit. Denn wer heute in Sprachtechnologie investiert, sichert sich morgen einen Platz an der Spitze.