Bestärkendes Lernen

Künstliche Intelligenz entwickelt sich sehr schnell. Reinforcement Learning ist dabei sehr wichtig. Es hilft Computern, sich selbst zu verbessern.

Im Gegensatz zu anderen Methoden lernt es durch Ausprobieren und Feedback. So entwickelt es eigene Strategien.

Ein intelligenter Agent lernt durch Interaktion mit seiner Umgebung. Er probiert verschiedene Handlungen aus und sieht, was passiert. Das ist ähnlich wie ein Kind, das durch Ausprobieren lernt.

Dieser dynamische Ansatz macht Reinforcement Learning sehr spannend. Es ist eine der spannendsten Technologien im Bereich des maschinellen Lernens.

Wichtigste Erkenntnisse

- Reinforcement Learning basiert auf Belohnungssystemen

- Agenten lernen durch direktes Interagieren mit Umgebungen

- Keine vorherige Datenbasis erforderlich

- Ermöglicht autonome Strategieentwicklung

- Anwendbar in komplexen Entscheidungssituationen

Grundlagen des bestärkenden Lernens

Reinforcement Learning (RL) ist ein spannendes Gebiet der künstlichen Intelligenz. Es konzentriert sich auf Lernen durch Interaktion und Erfahrung. Ein KI-Agent navigiert in einer komplexen Umgebung und entwickelt Strategien für optimale Ergebnisse.

Definition und Kernkonzepte

Das Herzstück von Reinforcement Learning ist das Trial-and-Error-Lernen. Der KI-Agent erkundet seine Umgebung und lernt durch systematische Interaktionen. Die wichtigsten Elemente sind:

- Der KI-Agent als zentraler Entscheidungsträger

- Die Umgebung als Interaktionsraum

- Das Belohnungssystem als Feedback-Mechanismus

Unterschiede zu anderen Lernmethoden

Reinforcement Learning ist anders als überwachtes Lernen, da es ohne vormarkierte Trainingsdaten arbeitet. Der Agent lernt durch direkte Erfahrungen und passt seine Strategien kontinuierlich an.

Historische Entwicklung

Die Geschichte von Reinforcement Learning beginnt in den 1950er Jahren. Es kam ursprünglich aus der Psychologie und Verhaltensforschung. Heute ist es ein zentrales Element moderner KI-Systeme.

Die Komponenten des Reinforcement Learning

Reinforcement Learning nutzt fünf wichtige Teile, um ein intelligentes Lernen zu ermöglichen. Diese Teile helfen einem Agenten, aus seiner Umgebung zu lernen. So kann er die besten Entscheidungen treffen.

- Agent: Das intelligente System, das Entscheidungen trifft und lernt

- Umgebung: Der Kontext, in dem der Agent agiert

- Zustände: Beschreiben die aktuelle Situation des Agenten

- Aktionen: Mögliche Entscheidungen, die der Agent ausführen kann

- Belohnungen: Feedback, das den Lernerfolg bewertet

Der Agent probiert verschiedene Aktionen in der Umgebung aus. Jede Aktion verändert den Zustand und kann eine Belohnung bringen. So lernt der Agent, wie er die höchsten Belohnungen erreichen kann.

Dieser Prozess verbessert die Entscheidungsfindung des Agenten ständig. Wie gut die Belohnungen sind und wie komplex die Umgebung ist, beeinflusst, wie gut er lernt.

Agent und Umgebung: Das Zusammenspiel

Reinforcement Learning ist spannend. Es geht um die Interaktion zwischen einem KI-Agenten und seiner Umgebung. Es ähnelt dem Lernen durch Erfahrung, bei dem man ständig besser wird.

Der KI-Agent ist das Zentrum des Lernens. Er nimmt Infos auf, entscheidet und bewertet die Folgen. Der Reinforcement Learning-Mechanismus hilft ihm, aus Erfahrungen zu lernen.

Aufbau des Agenten

Ein typischer KI-Agent hat mehrere wichtige Teile:

- Wahrnehmungsschnittstelle

- Entscheidungsalgorithmus

- Lernmechanismus

- Strategiespeicher

Interaktion mit der Umgebung

Die Interaktion mit der Umgebung ist sehr wichtig. Der Agent macht Aktionen, bekommt Rückmeldung und passt sich an. Ein Feedback-Loop hilft, ständig besser zu werden.

Feedback-Mechanismen

Feedback-Mechanismen bewerten, wie gut die Aktionen des Agenten sind. Belohnungen für Erfolge stärken gute Strategien. Schlechte Aktionen werden durch negative Belohnungen weniger wahrscheinlich.

Beispiele zeigen, wie das funktioniert. Ein Saugroboter lernt, effizient zu saugen. Ein Roboter navigiert durch ein Labyrinth. Beide lernen und passen sich an.

Belohnungssysteme und Feedback-Schleifen

Reinforcement Learning nutzt eine komplexe Belohnungsfunktion. So können KI-Systeme schwierige Entscheidungen treffen. Der Agent verbessert sich durch ständige Bewertung seiner Aktionen.

- Zustandserfassung des Agenten

- Entscheidungsfindung

- Bewertung durch Belohnungssystem

- Strategische Anpassung

Optimierungskriterien sind sehr wichtig. Sie helfen, effektive Lernstrategien zu entwickeln. Sie bestimmen, wie der Agent Belohnungen nutzt.

| Belohnungstyp | Wirkung | Beispiel |

|---|---|---|

| Positive Verstärkung | Erhöht Wahrscheinlichkeit erfolgreicher Aktionen | Punktegewinn in Spielsimulation |

| Negative Verstärkung | Reduziert unerwünschte Verhaltensweisen | Punkteabzug bei Fehlverhalten |

Die Belohnungsfunktion hilft dem Agenten, aus Erfahrungen zu lernen. Präzise Belohnungsmechanismen sind der Schlüssel zum Erfolg im maschinellen Lernen.

Das Markov-Entscheidungsproblem

Der Markov-Entscheidungsprozess (MDP) ist wichtig für fortschrittliche Entscheidungen. Er hilft Systemen, kluge Entscheidungen in unsicheren Situationen zu treffen.

Das Markov-Entscheidungsproblem untersucht Zustandsübergänge. Es nutzt mathematische Parameter für Entscheidungen:

- Zustände des Systems

- Mögliche Aktionen

- Übergangswahrscheinlichkeiten

- Belohnungsfunktionen

Mathematische Grundlagen

Die Mathematik hinter dem MDP ermöglicht genaue Modellierung. Algorithmen entwickeln so optimale Strategien. Ein KI-Modell nutzt diese Technik für Vorhersagen und Bewertungen.

Anwendung in der Praxis

MDP wird in vielen Bereichen eingesetzt, von Robotik bis Wirtschaft. Firmen verbessern ihre Entscheidungen und Ressourcenmanagement mit MDP-Algorithmen.

MDP ist stark, weil es ungewisse Situationen mathematisch versteht. Es entwickelt kluge Lösungen. Systeme können so flexibel auf Herausforderungen reagieren.

Strategien und Algorithmen

RL-Algorithmen sind wichtig, weil sie komplexe Strategien verbessern können. Sie helfen Agenten, kluge Entscheidungen zu treffen. Lernen durch Belohnung ist dabei sehr wichtig.

Es gibt zwei Hauptarten von Algorithmen:

- Modellbasierte Methoden: Lernen über Aktionsmodelle und Belohnungen

- Modellfreie Methoden: Finden direkt die besten Aktionen für jeden Zustand

Q-Learning ist ein wichtiger Algorithmus. Er hilft Agenten, durch Ausprobieren und Nutzen von Informationen, die besten Strategien zu finden.

| Algorithmus | Charakteristik | Anwendungsbereich |

|---|---|---|

| Q-Learning | Modellfrei, wertebasiert | Entscheidungsprobleme |

| Policy Gradient | Strategieorientiert | Kontinuierliche Aktionsräume |

| SARSA | On-Policy Methode | Zustandsbasierte Probleme |

Die Wahl des richtigen Algorithmus hängt von der Umgebung und den Zielen ab. Wichtig sind die Komplexität der Umgebung und die Art der Aktionen.

Q-Learning und Deep Q-Networks

Q-Learning und Deep Q-Networks (DQN) sind wichtig im Bereich der künstlichen Intelligenz. Sie helfen Agenten, kluge Entscheidungen in schwierigen Situationen zu treffen. Forscher haben diese Methoden entwickelt, um effizienter zu lernen.

Diese Techniken sind auf der Suche nach effizienten Lernstrategien entstanden.

Grundlagen des Q-Learning

Q-Learning ist ein Schlüsselkonzept zur Schätzung von Werten. Ein Agent lernt durch systematisches Erkunden und Lernen, die beste Strategie zu finden. Die wichtigsten Elemente sind:

- Speicherung von Erfahrungswerten in Zustandstabellen

- Bewertung von Aktionen basierend auf Belohnungen

- Kontinuierliche Verbesserung der Entscheidungsstrategie

Deep Q-Networks: Eine Evolution des Lernens

Deep Q-Networks (DQN) nutzen neuronale Netze, um Q-Learning zu verbessern. Sie können komplexe Umgebungen besser bearbeiten als herkömmliche Methoden.

DQN ermöglicht es Systemen, aus Erfahrungen zu lernen und sich anzupassen. Künstliche Intelligenz wird dadurch flexibler und adaptionsfähiger denn je.

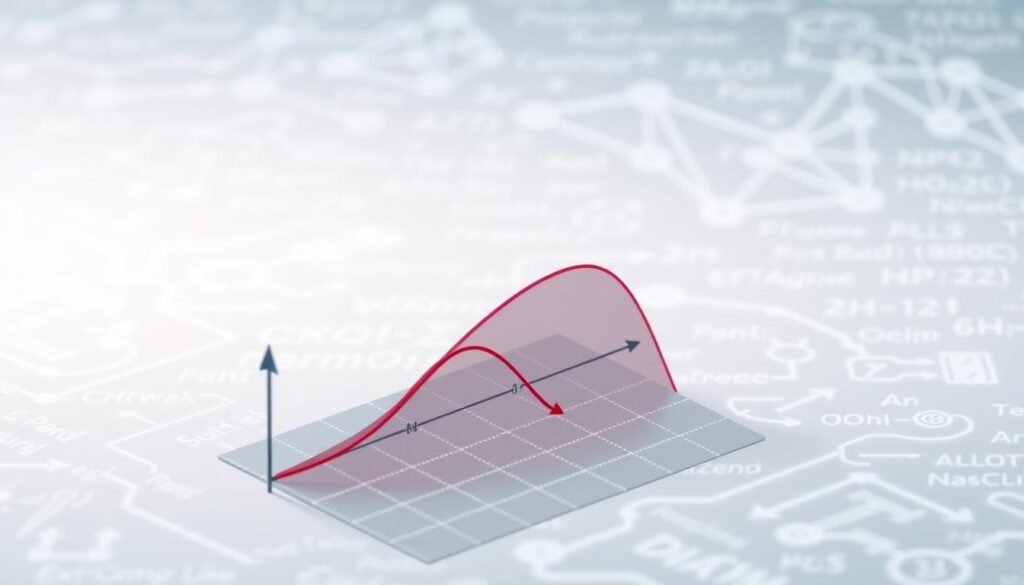

Policy Gradient Methoden

Policy Gradient Methoden sind wichtig im Reinforcement Learning. Sie verbessern die Strategie eines Agents direkt. Der REINFORCE-Algorithmus hilft dabei, die Belohnung zu maximieren.

Die Idee hinter diesen Methoden ist die Policy Optimization. Sie verbessern die Entscheidungsstrategie direkt. Das hat viele Vorteile:

- Direkte Optimierung der Agenten-Strategie

- Bessere Leistung in kontinuierlichen Aktionsräumen

- Flexibilität bei komplexen Problemstellungen

Der REINFORCE-Algorithmus nutzt Gradientenabstieg. Er erhöht die Wahrscheinlichkeit erfolgreicher Aktionen. So lernt der Agent ständig zu verbessern.

| Methode | Hauptcharakteristik | Anwendungsbereich |

|---|---|---|

| REINFORCE | Stochastische Gradientenoptimierung | Komplexe Entscheidungsräume |

| Actor-Critic | Kombinierte Wert- und Strategieschätzung | Dynamische Umgebungen |

| Proximal Policy Optimization | Stabilisierte Strategieaktualisierung | Robotik und Simulationen |

Policy Gradient Methoden verändern das Reinforcement Learning. Sie ermöglichen eine direkte und adaptive Verbesserung. Das öffnet neue Wege für intelligente Systeme in Robotik, Spielen und Autonomie.

Monte-Carlo Methoden im bestärkenden Lernen

Die Monte-Carlo-Simulation verändert das bestärkende Lernen. Sie nutzt einen neuen Ansatz des stichprobenbasierten Lernens. Künstliche Systeme können so komplexe Entscheidungen treffen.

Grundprinzipien der Monte-Carlo-Simulation

Die Monte-Carlo-Methoden basieren auf einem einfachen Prinzip. Sie nutzen Zufallsstichproben, um Werte zu ermitteln. So können Agenten Zustände und Aktionen besser einschätzen.

- Zufällige Episodengenerierung

- Durchschnittliche Belohnungsberechnung

- Iterative Wertverbesserung

Praktische Einsatzgebiete

Monte-Carlo-Methoden werden in vielen Bereichen eingesetzt. Dort, wo andere Methoden scheitern.

| Anwendungsbereich | Spezifische Nutzung |

|---|---|

| Finanzmodellierung | Risikobewertung und Portfoliooptimierung |

| Spieltheorie | Strategische Entscheidungsfindung |

| Robotik | Navigations- und Bewegungsplanung |

Stichprobenbasiertes Lernen hilft Systemen, aus wenig Daten starke Strategien zu entwickeln. Die Monte-Carlo-Simulation ermöglicht es Agenten, komplexe Umgebungen zu erkunden. So lernen sie, ohne alle Informationen.

Exploration vs. Exploitation

Im Bereich des Reinforcement Learning gibt es ein großes Problem: die Wahl zwischen Erkundung und Ausnutzung. Diese Entscheidung ist sehr wichtig für intelligente KI-Systeme. Sie müssen lernen und sich anpassen können.

Erkundungsstrategien helfen dabei, neue Zustände zu entdecken. Ein Agent muss neue Wege ausprobieren, um bessere Lösungen zu finden. Ausnutzungsstrategien nutzen hingegen das bekannte Wissen, um schnell Belohnungen zu bekommen.

- Exploration ermöglicht das Sammeln neuer Informationen

- Exploitation maximiert kurzfristige Belohnungen

- Der Schlüssel liegt in der optimalen Balance

Eine gute Lösung ist die ε-greedy Policy. Diese Strategie lässt den Agenten manchmal zufällig handeln. So entdeckt er neue Wege, nutzt aber auch die besten bekannten Optionen.

| Strategie | Ziel | Charakteristik |

|---|---|---|

| Exploration | Informationssammlung | Zufällige Aktionsauswahl |

| Exploitation | Belohnungsmaximierung | Bekannte optimale Aktionen |

Die Entscheidung zwischen Erkundung und Ausnutzung hängt vom Kontext ab. In komplexen Umgebungen kann zu viel Ausnutzung Lernchancen verpassen.

Anwendungsgebiete in der Praxis

Reinforcement Learning (RL) ist eine revolutionäre Technologie. Sie wird in vielen Bereichen eingesetzt. RL hilft, komplexe Probleme in verschiedenen Branchen zu lösen.

Robotik und Automation

In der Robotik zeigt RL beeindruckende Ergebnisse. Industrieroboter lernen durch RL-Algorithmen, wie sie sich bewegen. Sie passen sich auch schnell an neue Umgebungen an.

- Autonome Robotersysteme

- Präzise Bewegungssteuerung

- Adaptive Lernstrategien

Spieleentwicklung

RL verbessert die Spieleentwicklung enorm. Künstliche Intelligenz lernt durch Spiele, wie sie besser spielen können. So können sie Menschen herausfordern.

| Spielbereich | RL-Anwendung |

|---|---|

| Strategiespiele | Strategieentwicklung |

| Videospiele | Adaptive Gegner-KI |

Industrielle Prozesse

RL bringt in der Prozessautomatisierung große Fortschritte. Es optimiert komplexe Produktionsabläufe. So werden Ressourcen besser genutzt.

- Produktionsoptimierung

- Energiemanagement

- Predictive Maintenance

RL bietet Unternehmen neue Wege, Probleme zu lösen. Es wird eine wichtige Rolle in der digitalen Transformation spielen.

Herausforderungen und Limitationen

Reinforcement Learning (RL) bringt komplexe Probleme mit sich. Diese begrenzen den Einsatz dieser Technologie. Besonders die Skalierbarkeit von RL-Systemen ist ein großes Problem.

Zu den Hauptproblemen zählen:

- Datenkomplexität in hochdimensionalen Umgebungen

- Rechenintensive Lernprozesse

- Unvorhersehbare Konvergenzprobleme

In Multi-Agenten-Systemen gibt es große Herausforderungen. Wenn ein RL-System mit mehreren Agenten kooperieren soll, können Konvergenzprobleme auftreten. Wissenschaftler arbeiten an Lösungen, um diese Probleme zu überwinden.

Die Komplexität wächst schnell mit der Anzahl der Umgebungsvariablen. Bei einfachen Szenarien funktionieren traditionelle RL-Methoden gut. Aber bei komplexen Systemen versagen sie oft. Heuristische Strategien bieten manchmal praktikable Lösungen, auch ohne absolute Garantie.

Trotz der Herausforderungen bleibt Reinforcement Learning vielversprechend. Forscher arbeiten daran, die Grenzen zu erweitern und bessere Lernalgorithmen zu entwickeln.

Sicherheitsaspekte beim bestärkenden Lernen

Reinforcement Learning (RL) bringt viele neue Möglichkeiten. Doch es wirft auch wichtige Sicherheitsfragen auf. Die Sicherheit in RL ist sehr wichtig für intelligente Systeme.

Wissenschaftler arbeiten an starken RL-Systemen. Diese sollen Risiken verringern. Dabei ist die Risikoabschätzung sehr wichtig.

Risikomanagement in RL-Systemen

Experten setzen auf mehrere Sicherheitsmaßnahmen:

- Strikte Regeln setzen

- Viele Tests durchführen

- Ständige Überwachung

Implementierungssicherheit

Bei wichtigen Anwendungen muss man RL-Algorithmen genau steuern. Wichtig sind:

- Transparente Entscheidungsprozesse

- Vorhersagbare Reaktionen

- Sicherheitsmechanismen

Es ist eine große Herausforderung, Sicherheit und Innovation zu verbinden. Durch systematische Risikoabschätzung entstehen starke und vertrauenswürdige RL-Systeme.

Zukunftsperspektiven

Die Welt der künstlichen Intelligenz steht vor einer großen Veränderung. RL-Trends zeigen ein großes Potenzial für zukünftige Anwendungen. Diese könnten unsere Gesellschaft grundlegend verändern.

Aktuelle Entwicklungen in der KI, insbesondere im Reinforcement Learning, eröffnen spannende Perspektiven. Forscher sehen großes Potenzial in modellbasierten Methoden. Diese können komplexe Zusammenhänge in Bereichen wie Medizin, Sozialwissenschaften, Wirtschaft und Politik erforschen.

Causal Machine Learning wird immer wichtiger. Diese Technologie verbindet verschiedene Wissenschaftszweige. Sie ermöglicht tiefere Einblicke in komplexe Systeme.

Zukünftige Anwendungen von Reinforcement Learning versprechen bahnbrechende Innovationen. Intelligente Systeme werden selbstständig Entscheidungen treffen und aus Erfahrungen lernen.

Die Visionen reichen weit über traditionelle Anwendungsbereiche hinaus. Wir können erwarten, dass RL-Technologien:

- Personalisierte Gesundheitssysteme entwickeln

- Stadtplanungen optimieren

- Komplexe gesellschaftliche Herausforderungen lösen

- Interdisziplinäre Forschung revolutionieren

Die Grenzen zwischen Wissenschaftsdisziplinen verschwinden. Reinforcement Learning wird zum Katalysator für interdisziplinäre Durchbrüche.

Vergleich mit anderen KI-Methoden

Reinforcement Learning (RL) ist einzigartig im Vergleich zu anderen Methoden. Es basiert auf Interaktion und Belohnungssignalen. Das unterscheidet es von Supervised Learning und Unsupervised Learning.

- Supervised Learning braucht vorab gelabelte Daten

- Unsupervised Learning findet Muster ohne Vorwissen

- Reinforcement Learning lernt durch Aktion und Feedback

| Lernmethode | Hauptcharakteristik | Typische Anwendung |

|---|---|---|

| Supervised Learning | Lernen mit gelabelten Daten | Klassifikation, Vorhersagemodelle |

| Unsupervised Learning | Musterentdeckung ohne Labels | Clustering, Dimensionsreduktion |

| Reinforcement Learning | Lernen durch Interaktion | Strategische Entscheidungsfindung |

Hybride KI-Ansätze kombinieren Stärken verschiedener Methoden. Die Kombination von RL und Deep Learning bietet neue Chancen für komplexe Probleme.

Die richtige Lernmethode hängt vom Kontext ab. RL passt besonders zu Szenarien mit sequenziellen Entscheidungen und unbekannten Umgebungen.

Fazit

Unsere Reise durch die Welt des Reinforcement Learning (RL) zeigt, wie wichtig diese Technologie ist. Sie revolutioniert das maschinelle Lernen. RL kann komplexe Probleme lösen, ohne viele Daten vorher zu kennen.

Die Stärke von RL liegt in seiner Lernstrategie. Es entwickelt Lösungen, die Menschen nicht immer verstehen. Das macht RL zu einem Schlüssel für neue Möglichkeiten in der KI.

Es gibt aber auch Herausforderungen. Wir müssen Sicherheit, Ethik und Verständlichkeit der Algorithmen besser verstehen. Wie wir RL nutzen, wird entscheiden, wie die Zukunft des Lernens aussieht.

Reinforcement Learning ist mehr als eine Lernmethode. Es erweitert die Intelligenz von Maschinen auf neue Weise. Jeder Fortschritt bringt uns näher an intelligente und transformative Systeme.